Kubernetes学习(一)之认识Kubernetes

Kubernetes概念

简介

Kubernetes是一个跨主机集群的 开源的容器调度平台,它可以自动化应用容器的部署、扩展和操作 , 提供以容器为中心的基础架构。结合docker可以提供持续开发,持续部署的功能,我现在所从事开发的Choerodon就是基于这一套架构开发的企业级数字服务平台,具有敏捷化的应用交付和自动化的运营管理的特点。这里介绍的版本是v1.13

新的方式是通过部署容器方式实现,每个容器之间互相隔离,每个容器有自己的文件系统 ,容器之间进程不会相互影响,能区分计算资源。相对于虚拟机,容器能快速部署,由于容器与底层设施、机器文件系统解耦的,所以它能在不同云、不同版本操作系统间进行迁移。

容器占用资源少、部署快,每个应用可以被打包成一个容器镜像,每个应用与容器间成一对一关系也使容器有更大优势,使用容器可以在build或release 的阶段,为应用创建容器镜像,因为每个应用不需要与其余的应用堆栈组合,也不依赖于生产环境基础结构,这使得从研发到测试、生产能提供一致环境。类似地,容器比虚机轻量、更“透明”,这更便于监控和管理。

组件

Master组件

Kubernetes 主要由以下几个核心(Master)组件组成,Master组件提供集群的管理控制中心。Master组件可以在集群中任何节点上运行。但是为了简单起见,通常在一台VM/机器上启动所有Master组件,并且不会在此VM/机器上运行用户容器。请参考构建高可用群集以来构建multi-master-VM。

kube-apiserver

etcd

etcd是Kubernetes提供默认的存储系统,保存所有集群数据,使用时需要为etcd数据提供备份计划。

kube-scheduler

主服务器上的组件,用于监视未创建节点的新创建的pod,并选择一个节点供其运行。 调度决策所考虑的因素包括个人和集体资源需求,硬件/软件/策略约束,亲和力和反亲和性规范,数据位置,工作负载间干扰和最后期限。

kube-controller-manager

kube-controller-manager运行管理控制器,它们是集群中处理常规任务的后台线程。逻辑上,每个控制器是一个单独的进程,但为了降低复杂性,它们都被编译成单个二进制文件,并在单个进程中运行。负责维护集群的状态,比如故障检测、自动扩展、滚动更新等。

这些控制器包括:

- 节点(Node)控制器。

- 副本(Replication)控制器:负责维护系统中每个副本中的pod。

- 端点(Endpoints)控制器:填充Endpoints对象(即连接Services&Pods)。

- Service Account和Token控制器:为新的Namespace 创建默认帐户访问API Token。

cloud-controller-manager

云控制器管理器负责与底层云提供商的平台交互。云控制器管理器是Kubernetes版本1.6中引入的,目前还是Alpha的功能。

云控制器管理器仅运行云提供商特定的(controller loops)控制器循环。可以通过将--cloud-provider flag设置为external启动kube-controller-manager ,来禁用控制器循环。

cloud-controller-manager 具体功能:

- 节点(Node)控制器

- 路由(Route)控制器

- Service控制器

- 卷(Volume)控制器

节点(Node)组件

节点组件运行在Node,提供Kubernetes运行时环境,以及维护Pod。

kubelet

kubelet是主要的节点代理,它会监视已分配给节点的pod,负责维护容器的生命周期,同时也负责 Volume(CVI)和网络(CNI)的管理,具体功能:

- 安装Pod所需的volume。

- 下载Pod的Secrets。

- Pod中运行的 docker(或experimentally,rkt)容器。

- 定期执行容器健康检查。

- 通过在必要时创建镜像pod,将pod状态报告回系统的其余部分。

- 将节点的状态返回到系统的其余部分。

kube-proxy

kube-proxy通过在主机上维护网络规则并执行连接转发来实现Kubernetes服务抽象。负责为 Service 提供 cluster 内部的服务发现和负载均衡。

Container Runtime

容器运行时是负责运行容器的软件。 Kubernetes支持多种运行时:Docker,rkt,runc和任何OCI运行时规范实现。

插件

插件(addon)是实现集群pod和Services功能的 。PodDeployments,ReplicationController等进行管理。Namespace 插件对象是在kube-system Namespace中创建。有关可用插件的扩展列表,请参阅插件。

DNS

虽然不严格要求使用插件,但Kubernetes集群都应该具有DNS集群。

群集 DNS是一个DNS服务器,能够为 Kubernetes services提供 DNS记录。

由Kubernetes启动的容器自动将这个DNS服务器包含在他们的DNS searches中。

用户界面

仪表板是Kubernetes集群的基于Web的通用UI。它允许用户管理和解决群集中运行的应用程序以及群集本身。

容器资源监测

容器资源监控提供一个UI浏览监控数据。

Cluster-level Logging

Cluster-level logging,负责保存容器日志,搜索/查看日志。

supervisord

supervisord是一个轻量级的监控系统,用于保障kubelet和docker运行。

fluentd

fluentd是一个守护进程,可提供cluster-level logging。

The Kubernetes API

API约定文档中描述了总体API约定

API参考中描述了API端点,资源类型和示例。

Controlling API Access文档中讨论了对API的远程访问。

Kubernetes API还可用作系统声明性配置架构的基础。 kubectl命令行工具可用于创建,更新,删除和获取API对象。

Kubernetes还根据API资源存储其序列化状态(当前在etcd中)。

Kubernetes本身被分解为多个组件,通过其API进行交互。

- API更改

- OpenAPI和Swagger定义

- API版本控制

- API组

- 启用API组

- 启用组中的资源

API更改

根据我们的经验,任何成功的系统都需要随着新用例的出现或现有用例的变化而增长和变化。因此,我们希望Kubernetes API能够不断变化和发展。但是,我们打算在很长一段时间内不破坏与现有客户端的兼容性。通常,可以预期频繁添加新的API资源和新的资源字段。消除资源或字段将需要遵循API弃用策略。

OpenAPI和Swagger定义

使用OpenAPI记录完整的API详细信息。 从Kubernetes 1.10开始,Kubernetes API服务器通过/openapi/ v2端点提供OpenAPI规范。通过设置HTTP标头指定请求的格式:

| Header | Possible Values |

|---|---|

| Accept | application/json, application/com.github.proto-openapi.spec.v2@v1.0+protobuf (the default content-type is application/json for / or not passing this header) |

| Accept-Encoding | gzip (not passing this header is acceptable) |

在1.14之前,格式分离的端点(/swagger.json,/swagger-2.0.0.json,/swagger-2.0.0.pb-v1,/swagger-2.0.0.pb-v1.gz)为OpenAPI提供服务不同格式的规范。这些端点已弃用,将在Kubernetes 1.14中删除。

获取OpenAPI规范的示例:

| Before 1.10 | Starting with Kubernetes 1.10 |

|---|---|

| GET /swagger.json | GET /openapi/v2 Accept: application/json |

| GET /swagger-2.0.0.pb-v1 | GET /openapi/v2 Accept: application/com.github.proto-openapi.spec.v2@v1.0+protobuf |

| GET /swagger-2.0.0.pb-v1.gz | GET /openapi/v2 Accept: application/com.github.proto-openapi.spec.v2@v1.0+protobuf Accept-Encoding: gzip |

Kubernetes为API实现了另一种基于Protobuf的序列化格式,主要用于集群内通信,在设计提案中有记录,每个模式的IDL文件都位于定义API对象的Go包中。

在1.14之前,Kubernetes apiserver还公开了一个API,可用于检索/ swaggerapi上的Swagger v1.2 Kubernetes API规范。该端点已弃用,将在Kubernetes 1.14中删除。

API版本控制

为了更容易消除字段或重构资源表示,Kubernetes支持多个API版本,每个API版本位于不同的API路径,例如/api/v1或/apis/extensions/v1beta1。

我们选择在API级别而不是在资源或字段级别进行版本化,以确保API提供清晰,一致的系统资源和行为视图,并允许控制对生命末端和/或实验API的访问。 JSON和Protobuf序列化模式遵循相同的模式更改指南 - 以下所有描述都涵盖两种格式。

请注意,API版本控制和软件版本控制仅间接相关。 API和发布版本控制提议描述了API版本控制和软件版本控制之间的关系。

不同的API版本意味着不同级别的稳定性和支持。 API更改文档中更详细地描述了每个级别的标准。他们总结在这里:

Alpha level:

- 版本名称包含alpha(例如v1alpha1)。

- 可能是马车。启用该功能可能会暴露错误。默认情况下禁用。

- 可随时删除对功能的支持,恕不另行通知。

- API可能会在以后的软件版本中以不兼容的方式更改,恕不另行通知。

- 由于错误风险增加和缺乏长期支持,建议仅在短期测试集群中使用。

Beta level::

- 版本名称包含beta(例如v2beta3)。

- 代码经过了充分测试。启用该功能被认为是安全的。默认情况下启用。

- 虽然细节可能会有所变化,但不会删除对整体功能的支持。

- 在随后的beta版或稳定版中,对象的模式和/或语义可能以不兼容的方式发生变化。发生这种情况时,我们将提供迁移到下一版本的说明。这可能需要删除,编辑和重新创建API对象。编辑过程可能需要一些思考。对于依赖该功能的应用程序,这可能需要停机时间。

- 建议仅用于非关键业务用途,因为后续版本中可能存在不兼容的更改。如果您有多个可以独立升级的群集,您可以放宽此限制。

- 请尝试我们的测试版功能并提供反馈!一旦他们退出测试版,我们可能无法进行更多更改。

Stable level:

- 该版本名称是vX这里X是一个整数。

- 许多后续版本的已发布软件中将出现稳定版本的功能。

API组

为了更容易扩展Kubernetes API,我们实现了API组。API组在REST路径和apiVersion序列化对象的字段中指定。

目前有几个API组正在使用中:

- 核心组,常常被称为遗留组,是在REST路径

/api/v1和用途apiVersion: v1。 - 命名组处于REST路径

/apis/$GROUP_NAME/$VERSION,并使用apiVersion: $GROUP_NAME/$VERSION(例如apiVersion: batch/v1)。在Kubernetes API参考中可以看到支持的API组的完整列表。

使用自定义资源扩展API有两种受支持的路径:

- CustomResourceDefinition 适用于具有非常基本CRUD需求的用户。

- 需要完整Kubernetes API语义的用户可以实现自己的apiserver并使用聚合器 使其无缝地为客户端。

启用API组

默认情况下启用某些资源和API组。可以通过设置--runtime-config apiserver 来启用或禁用它们。--runtime-config接受逗号分隔值。例如:要禁用批处理/ v1,请设置 --runtime-config=batch/v1=false,以启用批处理/ v2alpha1,设置--runtime-config=batch/v2alpha1。该标志接受逗号分隔的一组key = value对,描述了apiserver的运行时配置。

重要信息:启用或禁用组或资源需要重新启动apiserver和controller-manager以获取--runtime-config更改。

启用组中的资源

默认情况下启用DaemonSet,Deployments,HorizontalPodAutoscalers,Ingresses,Jobs和ReplicaSet。可以通过设置--runtime-configapiserver 来启用其他扩展资源。--runtime-config接受逗号分隔值。例如:要禁用部署和入口,请设置 --runtime-config=extensions/v1beta1/deployments=false,extensions/v1beta1/ingresses=false

与Kubernetes对象一起工作

了解Kubernetes对象

了解Kubernetes对象

Kubernetes对象是Kubernetes系统中的持久实体。Kubernetes使用这些实体来表示集群的状态。具体来说,他们可以描述:

- 容器化应用正在运行(以及在哪些节点上)

- 这些应用可用的资源

- 关于这些应用如何运行的策略,如重新策略,升级和容错

Kubernetes对象是“record of intent”,一旦创建了对象,Kubernetes系统会确保对象存在。通过创建对象,可以有效地告诉Kubernetes系统你希望集群的工作负载是什么样的。

要使用Kubernetes对象(无论是创建,修改还是删除),都需要使用Kubernetes API。例如,当使用kubectl命令管理工具时,CLI会为提供Kubernetes API调用。你也可以直接在自己的程序中使用Kubernetes API,您还可以使用其中一个客户端库在您自己的程序中直接使用Kubernetes API。

对象(Object)规范和状态

每个Kubernetes对象都包含两个嵌套对象字段,用于管理Object的配置:Object Spec和Object Status。Spec描述了对象所需的状态 - 希望Object具有的特性,Status描述了对象的实际状态,并由Kubernetes系统提供和更新。

例如,通过Kubernetes Deployment 来表示在集群上运行的应用的对象。创建Deployment时,可以设置Deployment Spec,来指定要运行应用的三个副本。Kubernetes系统将读取Deployment Spec,并启动你想要的三个应用实例 - 来更新状态以符合之前设置的Spec。如果这些实例中有任何一个失败(状态更改),Kuberentes系统将响应Spec和当前状态之间差异来调整,这种情况下,将会开始替代实例。

有关object spec、status和metadata更多信息,请参考“Kubernetes API Conventions”。

描述Kubernetes对象

在Kubernetes中创建对象时,必须提供描述其所需Status的对象Spec,以及关于对象(如name)的一些基本信息。当使用Kubernetes API创建对象(直接或通过kubectl)时,该API请求必须将该信息作为JSON包含在请求body中。通常,可以将信息提供给kubectl .yaml文件,在进行API请求时,kubectl将信息转换为JSON。

以下示例是一个.yaml文件,显示Kubernetes Deployment所需的字段和对象Spec:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20#application/deployment.yaml

apiVersion: apps/v1 # for versions before 1.9.0 use apps/v1beta2

kind: Deployment

metadata:

name: nginx-deployment

spec:

selector:

matchLabels:

app: nginx

replicas: 2 # tells deployment to run 2 pods matching the template

template:

metadata:

labels:

app: nginx

spec:

containers:

- name: nginx

image: nginx:1.7.9

ports:

- containerPort: 80

使用上述.yaml文件创建Deployment,是通过在kubectl中使用kubectl create命令来实现。将该.yaml文件作为参数传递。如下例子:1

2$ kubectl create -f https://k8s.io/examples/application/deployment.yaml --record

deployment.apps/nginx-deployment created

必填字段

对于要创建的Kubernetes对象的yaml文件,需要为以下字段设置值:

- apiVersion - 创建对象的Kubernetes API 版本

- kind - 要创建什么样的对象?

- metadata- 具有唯一标示对象的数据,包括 name(字符串)、UID和Namespace(可选项)

您还需要提供对象规范字段。对象规范的精确格式对于每个Kubernetes对象都是不同的,并且包含特定于该对象的嵌套字段。 Kubernetes API Reference可以帮助您找到可以使用Kubernetes创建的所有对象的规范格式。例如,可以在此处找到Pod对象的spec格式,可以在此处找到Deployment对象的spec格式。

name

Kubernetes REST API中的所有对象都由Name和UID明确标识。

对于非唯一的用户提供的属性,Kubernetes提供标签和注释。

有关名称和UID的精确语法规则,请参阅标识符设计文档。

- Names

- UIDs

Names

客户端提供的字符串,用于引用资源URL中的对象,例如/api/v1/pods/some-name。

只有给定类型的一个对象一次可以有一个给定的名称。但是,如果删除该对象,则可以创建具有相同名称的新对象。

按照惯例,Kubernetes资源的名称应最多为253个字符,并且由小写字母数字字符组成-,并且.,但某些资源具有更具体的限制。

UIDs

Kubernetes系统生成的字符串,用于唯一标识对象。

在Kubernetes集群的整个生命周期中创建的每个对象都具有不同的UID。它旨在区分类似实体的历史事件。

Namespaces

Kubernetes支持由同一物理集群支持的多个虚拟集群。这些虚拟集群称为名称空间。

- 何时使用多个命名空间

- 使用命名空间

- 命名空间和DNS

- 并非所有对象都在命名空间中

何时使用多个命名空间

命名空间旨在用于多个用户分布在多个团队或项目中的环境中。对于具有几个到几十个用户的集群,您根本不需要创建或考虑名称空间。当您需要它们提供的功能时,请开始使用命名空间。

命名空间提供名称范围。资源名称在名称空间中必须是唯一的,而不是跨名称空间。

命名空间是一种在多个用户之间划分群集资源的方法(通过资源配额)。

在Kubernetes的未来版本中,默认情况下,同一名称空间中的对象将具有相同的访问控制策略。

没有必要使用多个名称空间来分隔略有不同的资源,例如同一软件的不同版本:使用标签来区分同一名称空间中的资源。

使用命名空间

名称空间的管理指南文档中描述了名称空间的创建和删除。

查看名称空间

您可以使用以下命令列出集群中的当前名称空间:1

2

3

4

5$ kubectl get namespaces

NAME STATUS AGE

default Active 1d

kube-system Active 1d

kube-public Active 1d

Kubernetes以三个初始名称空间开头:

default没有其他命名空间的对象的默认命名空间kube-systemKubernetes系统创建的对象的命名空间kube-public此命名空间是自动创建的,并且所有用户(包括未经过身份验证的用户)都可以读取。此命名空间主要用于群集使用,以防某些资源在整个群集中可见且可公开读取。此命名空间的公共方面只是一个约定,而不是一个要求。

设置请求的命名空间

要临时设置请求的命名空间,请使用该--namespace标志。

例如:1

2$ kubectl --namespace=<insert-namespace-name-here> run nginx --image=nginx

$ kubectl --namespace=<insert-namespace-name-here> get pods

设置命名空间首选项

您可以在该上下文中为所有后续kubectl命令永久保存命名空间。

1 | $ kubectl config set-context $(kubectl config current-context) --namespace=<insert-namespace-name-here> |

命名空间和DNS

创建服务时,它会创建相应的DNS条目。此条目是表单<service-name>.<namespace-name>.svc.cluster.local,这意味着如果容器只是使用<service-name>,它将解析为命名空间本地的服务。这对于在多个名称空间(如开发,分段和生产)中使用相同的配置非常有用。如果要跨命名空间访问,则需要使用完全限定的域名(FQDN)。

并非所有对象都在命名空间中

大多数Kubernetes资源(例如pod,服务,复制控制器等)都在某些名称空间中。但是,命名空间资源本身并不在命名空间中。并且低级资源(例如节点和persistentVolumes)不在任何名称空间中。

要查看哪些Kubernetes资源在命名空间中,哪些不在:1

2

3

4

5 In a namespace

kubectl api-resources --namespaced=true

Not in a namespace

kubectl api-resources --namespaced=false

Labels and Selectors

标签是附加到对象(例如pod)的键/值对。标签旨在用于指定对用户有意义且相关的对象的标识属性,但不直接暗示核心系统的语义。标签可用于组织和选择对象的子集。标签可以在创建时附加到对象,随后可以随时添加和修改。每个对象都可以定义一组键/值标签。每个Key对于给定对象必须是唯一的。1

2

3

4

5

6"metadata": {

"labels": {

"key1" : "value1",

"key2" : "value2"

}

}

标签允许高效的查询和监视,非常适合在UI和CLI中使用。应使用注释记录非识别信息。

- 动机

- 语法和字符集

- 标签选择器

- API

动机

标签使用户能够以松散耦合的方式将他们自己的组织结构映射到系统对象,而无需客户端存储这些映射。

服务部署和批处理流水线通常是多维实体(例如,多个分区或部署,多个释放轨道,多个层,每层多个微服务)。管理通常需要交叉操作,这打破了严格的层次表示的封装,特别是由基础设施而不是用户确定的严格的层次结构。

示例标签:

"release" : "stable","release" : "canary""environment" : "dev","environment" : "qa","environment" : "production""tier" : "frontend","tier" : "backend","tier" : "cache""partition" : "customerA","partition" : "customerB""track" : "daily","track" : "weekly"

这些只是常用标签的例子; 你可以自由地制定自己的约定。请记住,标签Key对于给定对象必须是唯一的。

语法和字符集

标签是键/值对。有效标签键有两个段:可选前缀和名称,用斜杠(/)分隔。名称段是必需的,必须是63个字符或更少,以字母数字字符([a-z0-9A-Z])开头和结尾,带有破折号(-),下划线(_),点(.)和字母数字之间。前缀是可选的。如果指定,前缀必须是DNS子域:由点(.)分隔的一系列DNS标签,总共不超过253个字符,后跟斜杠(/)。

如果省略前缀,则假定标签Key对用户是私有的。自动化系统组件(例如kube-scheduler,kube-controller-manager,kube-apiserver,kubectl,或其他第三方自动化),它添加标签终端用户对象都必须指定一个前缀。

在kubernetes.io/和k8s.io/前缀保留给Kubernetes核心组件。

有效标签值必须为63个字符或更少,并且必须为空或以字母数字字符([a-z0-9A-Z])开头和结尾,并带有短划线(-),下划线(_),点(.)和字母数字。

标签选择器

与名称和UID不同,标签不提供唯一性。通常,我们希望许多对象携带相同的标签。

通过标签选择器,客户端/用户可以识别一组对象。标签选择器是Kubernetes中的核心分组原语。

目前,API支持两种类型的选择:基于平等,和基于集的。标签选择器可以由逗号分隔的多个要求组成。在多个要求的情况下,必须满足所有要求,因此逗号分隔符充当逻辑AND(&&)运算符。

空或非指定选择器的语义取决于上下文,使用选择器的API类型应记录它们的有效性和含义。

注意:对于某些API类型(例如ReplicaSet),两个实例的标签选择器不得在命名空间内重叠,或者控制器可以将其视为冲突的指令,并且无法确定应存在多少副本。

基于平等的要求

基于平等或不平等的要求允许按标签键和值进行过滤。匹配对象必须满足所有指定的标签约束,尽管它们也可能有其他标签。三种操作都承认=,==,!=。前两个代表平等(简单地说是同义词),而后者代表不平等。例如:1

2environment = production

tier != frontend

前者选择密钥等于environment和值等于的所有资源production。后者选择密钥等于tier和值不同的frontend所有资源,以及没有带tier密钥标签的所有资源。可以过滤使用逗号运算符production排除的资源frontend:environment=production,tier!=frontend

基于等同的标签要求的一种使用场景是Pods指定节点选择标准。例如,下面的示例Pod选择标签为“ accelerator=nvidia-tesla-p100”的节点。1

2

3

4

5

6

7

8

9

10

11

12

13apiVersion: v1

kind: Pod

metadata:

name: cuda-test

spec:

containers:

- name: cuda-test

image: "k8s.gcr.io/cuda-vector-add:v0.1"

resources:

limits:

nvidia.com/gpu: 1

nodeSelector:

accelerator: nvidia-tesla-p100

基于集合的要求

基于集合的标签要求允许根据一组值过滤密钥。三种操作的支持:in,notin和exists(仅密钥标识符)。例如:1

2

3

4environment in (production, qa)

tier notin (frontend, backend)

partition

!partition

第一个示例选择键等于environment和值等于production或的所有资源qa。第二个示例选择密钥等于tier和除了frontend和之外的值的backend所有资源,以及没有带tier密钥标签的所有资源。第三个例子选择所有资源,包括带密钥的标签partition; 没有检查值。第四个示例选择没有带键的标签的所有资源partition; 没有检查值。类似地,逗号分隔符充当AND运算符。因此,使用partition密钥(无论值)和environment不同的 过滤资源qa都可以实现partition,environment notin (qa)。基于集合标签选择器是一种平等的一般形式,因为environment=production它等同于environment in (production); 同样的!=和notin。

基于集合的需求可以与基于相等的需求相结合。例如:partition in (customerA, customerB),environment!=qa。

API

LIST和WATCH过滤

LIST和WATCH操作可以指定标签选择器来过滤使用查询参数返回的对象集。这两个要求都是允许的(在此处显示为出现在URL查询字符串中):

- 基于平等的要求:

?labelSelector=environment%3Dproduction,tier%3Dfrontend - 基于集合的要求:

?labelSelector=environment+in+%28production%2Cqa%29%2Ctier+in+%28frontend%29

两种标签选择器样式都可用于通过REST客户端列出或查看资源。例如,靶向apiserver与kubectl和使用基于平等-一个可写:1

$ kubectl get pods -l environment=production,tier=frontend

或使用基于集合的要求:1

$ kubectl get pods -l 'environment in (production),tier in (frontend)'

如前所述,基于集合的要求更具表现力。例如,他们可以在值上实现OR运算符:1

kubectl get pods -l 'environment in (production, qa)'

或限制负匹配通过存在操作者:1

kubectl get pods -l 'environment,environment notin (frontend)'

在API对象中设置引用

某些Kubernetes对象(例如services和replicationcontrollers)也使用标签选择器来指定其他资源集,例如pod。

服务和ReplicationController

service使用标签选择器定义目标的一组pod 。类似地,replicationcontroller应该管理的pod的数量也用标签选择器定义。

两个对象的标签选择器在使用映射定义json或yaml文件中定义,并且仅支持基于等同的需求选择器:1

2

3"selector": {

"component" : "redis",

}

要么1

2selector:

component: redis

这个选择器(分别以json或yaml格式)相当于component=redis或component in (redis)。

支持基于集合的需求的资源

较新的资源,如Job,Deployment,Replica Set,和Daemon Set,支持基于集合的要求也是如此。1

2

3

4

5

6selector:

matchLabels:

component: redis

matchExpressions:

- {key: tier, operator: In, values: [cache]}

- {key: environment, operator: NotIn, values: [dev]}

matchLabels是对的地图{key,value}。一个单一的{key,value}在matchLabels地图相当于一个元件matchExpressions,其key字段是“key”,则operator是“In”和values阵列仅包含“value”。matchExpressions是一个pod选择器要求列表。有效的运算符包括In,NotIn,Exists和DoesNotExist。在In和NotIn的情况下,设置的值必须是非空的。所有的要求,从两者matchLabels和matchExpressionsAND一起 - 他们必须满足,以匹配。

选择节点集

用于选择标签的一个用例是约束pod可以调度的节点集。有关更多信息,请参阅有关节点选择的文档。

Annotations

您可以使用Kubernetes注释将任意非标识元数据附加到对象。工具和库等客户端可以检索此元数据。

- 将元数据附加到对象

- 语法和字符集

将元数据附加到对象

您可以使用标签或注释将元数据附加到Kubernetes对象。标签可用于选择对象和查找满足特定条件的对象集合。相反,注释不用于识别和选择对象。注释中的元数据可以是小的或大的,结构化的或非结构化的,并且可以包括标签不允许的字符。

注释(如标签)是键/值映射1

2

3

4

5

6"metadata": {

"annotations": {

"key1" : "value1",

"key2" : "value2"

}

}

以下是可以在注释中记录的一些信息示例:

- 由声明性配置层管理的字段。将这些字段作为注释附加,可以将它们与客户端或服务器设置的默认值以及自动生成的字段和自动调整大小或自动调整系统设置的字段区分开来。

- 构建,发布或映像信息,如时间戳,版本ID,git分支,PR编号,镜像哈希和仓库地址。

- 指向日志记录,监视,分析或审计存储库的指针。

- 可用于调试目的的客户端库或工具信息:例如,名称,版本和构建信息。

- 用户或工具/系统出处信息,例如来自其他生态系统组件的相关对象的URL。

- 轻量推出工具元数据:例如,配置或检查点。

- 负责人的电话或寻呼机号码,或指定可在何处找到该信息的目录条目,例如团队网站。

- 从最终用户到实现的指令,用于修改行为或使用非标准功能。

您可以将此类信息存储在外部数据库或目录中,而不是使用注释,但这会使生成用于部署,管理,内省等的共享客户端库和工具变得更加困难。

语法和字符集

注释是键/值对。有效的注释键有两个段:可选的前缀和名称,用斜杠(/)分隔。名称段是必需的,必须是63个字符或更少,以字母数字字符([a-z0-9A-Z])开头和结尾,带有破折号(-),下划线(_),点(.)和字母数字之间。前缀是可选的。如果指定,前缀必须是DNS子域:由点(.)分隔的一系列DNS标签,总共不超过253个字符,后跟斜杠(/)。

如果省略前缀,则假定注释密钥对用户是私有的。自动化系统组件(例如kube-scheduler,kube-controller-manager,kube-apiserver,kubectl,或其他第三方自动化)的添加注释到最终用户的对象都必须指定一个前缀。

在kubernetes.io/和k8s.io/前缀保留给Kubernetes核心组件。

Field Selectors

- 支持的字段

- 支持操作

- 链式选择器

- 多种资源类型

字段选择器允许您根据一个或多个资源字段的值选择Kubernetes资源。以下是一些示例字段选择器查询:

metadata.name=my-servicemetadata.namespace!=defaultstatus.phase=Pending

此kubectl命令选择status.phase字段值为的所有Pod Running:1

$ kubectl get pods --field-selector status.phase=Running

注意:

字段选择器本质上是资源过滤器。默认情况下,不应用选择器/过滤器,这意味着将选择指定类型的所有资源。这使以下kubectl查询等效:

2

$ kubectl pods ---selector ""

支持的字段

支持的字段选择器因Kubernetes资源类型而异。所有资源类型都支持metadata.name和metadata.namespace字段。使用不受支持的字段选择器会产生错误。例如:1

2$ kubectl get ingress --field-selector foo.bar=baz

Error from server (BadRequest): Unable to find "ingresses" that match label selector "", field selector "foo.bar=baz": "foo.bar" is not a known field selector: only "metadata.name", "metadata.namespace"

支持操作

您可以使用=,==以及!=与现场选择操作(=和==意思是一样的)。kubectl例如,此命令选择不在default命名空间中的所有Kubernetes服务:1

$ kubectl get services --field-selector metadata.namespace!=default

链式选择器

与标签和其他选择器一样,字段选择器可以作为逗号分隔列表链接在一起。此kubectl命令选择status.phase不相等Running且spec.restartPolicy字段等于的所有Pod Always:1

$ kubectl get pods --field-selector=status.phase!=Running,spec.restartPolicy=Always

多种资源类型

您可以跨多种资源类型使用字段选择器。此kubectl命令选择不在default命名空间中的所有Statefulsets和Services :1

$ kubectl get statefulsets,services --field-selector metadata.namespace!=default

Recommended Labels

您可以使用比kubectl和仪表板更多的工具来可视化和管理Kubernetes对象。一组通用的标签允许工具以互操作的方式工作,以所有工具都能理解的通用方式描述对象。

除支持工具外,推荐标签还以可查询的方式描述应用程序。

- 标签

- 应用程序和应用程序实例

- 例子

元数据围绕应用程序的概念进行组织。Kubernetes不是一个服务平台(PaaS),也没有或强制执行正式的应用程序概念。相反,应用程序是非正式的,并使用元数据进 应用程序包含的内容的定义是松散的。

注意:这些是推荐标签。它们使管理应用程序变得更容易,但对于任何核心工具都不是必需的。

共享标签和注释共享一个共同的前缀:app.kubernetes.io。没有前缀的标签对用户是私有的。共享前缀可确保共享标签不会干扰自定义用户标签。

标签

为了充分利用这些标签,应将它们应用于每个资源对象。

| 键 | 描述 | 例 | 类型 |

|---|---|---|---|

| app.kubernetes.io/name | 应用程序的名称 | string | mysql |

| app.kubernetes.io/instance | 标识应用程序实例的唯一名称 | string | wordpress-abcxzy |

| app.kubernetes.io/version | 应用程序的当前版本(例如,语义版本,修订版哈希等) | string | 5.7.21 |

| app.kubernetes.io/component | 架构中的组件 | string | database |

| app.kubernetes.io/part-of | 此级别的更高级别应用程序的名称 | string | wordpress |

| app.kubernetes.io/managed-by | 该工具用于管理应用程序的操作 | string | helm |

要说明这些标签的运行情况,请考虑以下StatefulSet对象:1

2

3

4

5

6

7

8

9

10apiVersion: apps/v1

kind: StatefulSet

metadata:

labels:

app.kubernetes.io/name: mysql

app.kubernetes.io/instance: wordpress-abcxzy

app.kubernetes.io/version: "5.7.21"

app.kubernetes.io/component: database

app.kubernetes.io/part-of: wordpress

app.kubernetes.io/managed-by: helm

应用程序和应用程序实例

应用程序可以一次或多次安装到Kubernetes集群中,在某些情况下,可以安装在同一名称空间中。例如,wordpress可以不止一次安装,其中不同的网站是wordpress的不同安装。

应用程序的名称和实例名称分别记录。例如,在WordPress具有app.kubernetes.io/name的wordpress,同时它有一个实例名,被表示为app.kubernetes.io/instance具有值 wordpress-abcxzy。这使得应用程序的应用程序和实例可以识别。应用程序的每个实例都必须具有唯一的名称。

例子

为了说明使用这些标签的不同方式,以下示例具有不同的复杂性。

一种简单的无状态服务

考虑使用Deployment和Service对象部署的简单无状态服务的情况。以下两个代码段表示如何以最简单的形式使用标签。

本Deployment是用来监督运行应用程序本身的豆荚。1

2

3

4

5

6

7apiVersion: apps/v1

kind: Deployment

metadata:

labels:

app.kubernetes.io/name: myservice

app.kubernetes.io/instance: myservice-abcxzy

...

将Service用于公开应用程序。1

2

3

4

5

6

7apiVersion: v1

kind: Service

metadata:

labels:

app.kubernetes.io/name: myservice

app.kubernetes.io/instance: myservice-abcxzy

...

使用数据库的Web应用程序

考虑一个稍微复杂的应用程序:使用Helm安装的使用数据库(MySQL)的Web应用程序(WordPress)。以下代码段说明了用于部署此应用程序的对象的开始。

以下Deployment内容用于WordPress:1

2

3

4

5

6

7

8

9

10

11apiVersion: apps/v1

kind: Deployment

metadata:

labels:

app.kubernetes.io/name: wordpress

app.kubernetes.io/instance: wordpress-abcxzy

app.kubernetes.io/version: "4.9.4"

app.kubernetes.io/managed-by: helm

app.kubernetes.io/component: server

app.kubernetes.io/part-of: wordpress

...

将Service用于公开WordPress的:1

2

3

4

5

6

7

8

9

10

11apiVersion: v1

kind: Service

metadata:

labels:

app.kubernetes.io/name: wordpress

app.kubernetes.io/instance: wordpress-abcxzy

app.kubernetes.io/version: "4.9.4"

app.kubernetes.io/managed-by: helm

app.kubernetes.io/component: server

app.kubernetes.io/part-of: wordpress

...

MySQL作为一个StatefulSet包含它的元数据和它所属的更大的应用程序公开:1

2

3

4

5

6

7

8

9

10

11apiVersion: apps/v1

kind: StatefulSet

metadata:

labels:

app.kubernetes.io/name: mysql

app.kubernetes.io/instance: wordpress-abcxzy

app.kubernetes.io/managed-by: helm

app.kubernetes.io/component: database

app.kubernetes.io/part-of: wordpress

app.kubernetes.io/version: "5.7.21"

...

将Service用于公开MySQL作为WordPress的部分:1

2

3

4

5

6

7

8

9

10

11apiVersion: v1

kind: Service

metadata:

labels:

app.kubernetes.io/name: mysql

app.kubernetes.io/instance: wordpress-abcxzy

app.kubernetes.io/managed-by: helm

app.kubernetes.io/component: database

app.kubernetes.io/part-of: wordpress

app.kubernetes.io/version: "5.7.21"

...

使用MySQL StatefulSet,Service您会注意到有关MySQL和Wordpress的信息,包括更广泛的应用程序。

对象管理使用kubectl

Kubernetes对象管理

该kubectl命令行工具支持多种不同的方法来创建和管理Kubernetes对象。本文档概述了不同的方法。

- 管理技巧

- 命令式命令

- 势在必行的对象配置

- 声明性对象配置

管理技巧

警告:应仅使用一种技术管理Kubernetes对象。对同一对象的混合和匹配技术会导致未定义的行为。

| Management technique | 操作 | 推荐环境 | Supported writers | Learning curve |

|---|---|---|---|---|

| Imperative commands | Live objects | Development projects | 1+ | Lowest |

| Imperative object configuration | Individual files | Production projects | 1 | Moderate |

| Declarative object configuration | Directories of files | Production projects | 1+ | Highest |

命令式命令

使用命令性命令时,用户直接在群集中的活动对象上操作。用户将kubectl命令的操作作为参数或标志提供。

这是在集群中启动或运行一次性任务的最简单方法。由于此技术直接在活动对象上运行,因此它不提供先前配置的历史记录。

例子

通过创建Deployment对象来运行nginx容器的实例:1

kubectl run nginx --image nginx

使用不同的语法执行相同的操作:1

kubectl create deployment nginx --image nginx

权衡

与对象配置相比的优点:

- 命令简单易学,易记。

- 命令只需要一个步骤即可对集群进行更改。

与对象配置相比的缺点:

- 命令不与更改审核过程集成。

- 命令不提供与更改关联的审计跟踪。

- 除了活动之外,命令不提供记录源。

- 命令不提供用于创建新对象的模板。

势在必行的对象配置

在命令式对象配置中,kubectl命令指定操作(创建,替换等),可选标志和至少一个文件名。指定的文件必须包含YAML或JSON格式的对象的完整定义。

有关 对象定义的更多详细信息,请参阅API参考。

警告:

replace命令式命令将现有规范替换为新提供的规范,删除对配置文件中缺少的对象的所有更改。此方法不应与其配置文件独立更新的资源类型一起使用。LoadBalancer例如,类型的服务使其externalIPs字段独立于群集的配置而更新。

例子

创建配置文件中定义的对象:1

kubectl create -f nginx.yaml

删除两个配置文件中定义的对象:1

kubectl delete -f nginx.yaml -f redis.yaml

通过覆盖实时配置来更新配置文件中定义的对象:1

kubectl replace -f nginx.yaml

权衡

与命令式命令相比的优点:

- 对象配置可以存储在诸如Git的源控制系统中。

- 对象配置可以与进程集成,例如在推送和审计跟踪之前查看更改。

- 对象配置提供了用于创建新对象的模板。

与命令式命令相比的缺点:

- 对象配置需要对对象模式有基本的了解。

- 对象配置需要编写YAML文件的附加步骤。

与声明对象配置相比的优点:

- 命令式对象配置行为更简单,更易于理解。

- 从Kubernetes 1.5版开始,命令式对象配置更加成熟。

与声明对象配置相比的缺点:

- 命令对象配置最适合文件,而不是目录。

- 活动对象的更新必须反映在配置文件中,否则在下次更换时会丢失。

声明性对象配置

使用声明性对象配置时,用户对本地存储的对象配置文件进行操作,但是用户不定义要对文件执行的操作。每个对象自动检测创建,更新和删除操作kubectl。这使得能够处理目录,其中可能需要不同对象的不同操作。

注意:声明性对象配置保留其他编写者所做的更改,即使更改未合并回对象配置文件也是如此。这可以通过使用

patchAPI操作来仅写入观察到的差异,而不是使用replaceAPI操作来替换整个对象配置。

例子

处理目录中的所有对象配置文件configs,并创建或修补活动对象。您可以先diff查看要进行的更改,然后应用:

1 | kubectl diff -f configs/ |

递归处理目录:1

2kubectl diff -R -f configs/

kubectl apply -R -f configs/

权衡

与命令式对象配置相比的优点:

- 即使它们未合并回配置文件,也会保留直接对活动对象所做的更改。

- 声明性对象配置更好地支持对目录进行操作并自动检测每个对象的操作类型(创建,修补,删除)。

与命令式对象配置相比的缺点:

- 声明性对象配置更难以调试,并在意外时理解结果。

- 使用diff的部分更新会创建复杂的合并和修补操作。

使用命令式命令管理Kubernetes对象

可以使用命令kubectl行工具中内置的命令性命令直接创建,更新和删除Kubernetes对象。本文档说明了如何组织这些命令以及如何使用它们来管理实时对象。

- 权衡

- 如何创建对象

- 如何更新对象

- 如何删除对象

- 如何查看对象

- 使用set命令在创建之前修改对象

- 使用–edit修改之前创建的对象

权衡

该kubectl工具支持三种对象管理:

- 命令式命令

- 势在必行的对象配置

- 声明性对象配置

有关每种对象管理 的优缺点的讨论,请参阅Kubernetes对象管理。

如何创建对象

该kubectl工具支持动词驱动的命令,用于创建一些最常见的对象类型。这些命令被命名为不熟悉Kubernetes对象类型的用户可识别。

run:创建一个新的Deployment对象以在一个或多个Pod中运行Container。expose:创建一个新的服务对象,以跨Pod调整流量负载。autoscale:创建新的Autoscaler对象以自动水平扩展控制器,例如部署。

该kubectl工具还支持由对象类型驱动的创建命令。这些命令支持更多对象类型,并且更明确地表达了它们的意图,但要求用户知道他们打算创建的对象的类型。

create <objecttype> [<subtype>] <instancename>

某些对象类型具有您可以在create命令中指定的子类型。例如,Service对象有几个子类型,包括ClusterIP,LoadBalancer和NodePort。这是一个使用子类型NodePort创建服务的示例:1

kubectl create service nodeport <myservicename>

在前面的示例中,该create service nodeport命令称为命令的子create service命令。

您可以使用该-h标志来查找子命令支持的参数和标志:1

kubectl create service nodeport -h

如何更新对象

该kubectl命令支持一些常见更新操作的动词驱动命令。命名这些命令是为了使不熟悉Kubernetes对象的用户能够在不知道必须设置的特定字段的情况下执行更新:

scale:通过更新控制器的副本计数,水平缩放控制器以添加或删除Pod。annotate:在对象中添加或删除注释。label:在对象中添加或删除标签。

该kubectl命令还支持由对象的一个方面驱动的更新命令。设置此方面可以为不同的对象类型设置不同的字段:

- set :设置对象的一个方面。

注意:在Kubernetes 1.5版中,并非每个动词驱动的命令都有一个关联的方面驱动命令。

该kubectl工具支持这些直接更新实时对象的其他方法,但是它们需要更好地理解Kubernetes对象模式。

edit:通过在编辑器中打开其配置,直接编辑活动对象的原始配置。patch:使用补丁字符串直接修改活动对象的特定字段。有关修补程序字符串的更多详细信息,请参阅API约定中的修补程序部分 。

如何删除对象

您可以使用该delete命令从群集中删除对象:

delete <type>/<name>

注意:您可以使用

kubectl delete命令式命令和命令式对象配置。不同之处在于传递给命令的参数。要kubectl delete用作命令性命令,请将要删除的对象作为参数传递。这是一个传递名为nginx的Deployment对象的示例:

1 | kubectl delete deployment/nginx |

如何查看对象

有几个命令用于打印有关对象的信息:

get:打印有关匹配对象的基本信息。使用get -h查看选项列表。describe:打印有关匹配对象的聚合详细信息。logs:为在Pod中运行的容器打印stdout和stderr。

使用set命令在创建之前修改对象

有些对象字段没有可在create命令中使用的标志。在一些案件中,可以使用的组合 set并create指定对象创建前场的值。这是通过将create命令的输出传递给 set命令,然后返回到create命令来完成的。这是一个例子:

1 | kubectl create service clusterip my-svc --clusterip="None" -o yaml --dry-run | kubectl set selector --local -f - 'environment=qa' -o yaml | kubectl create -f - |

- 该

kubectl create service -o yaml --dry-run命令为服务创建配置,但将其作为YAML打印到stdout,而不是将其发送到Kubernetes API服务器。 - 该

kubectl set selector --local -f - -o yaml命令从stdin读取配置,并将更新的配置作为YAML写入stdout。 - 该

kubectl create -f -命令使用stdin提供的配置创建对象。

使用–edit修改之前创建的对象

您可以kubectl create --edit在创建对象之前对其进行任意更改。这是一个例子:1

2kubectl create service clusterip my-svc --clusterip="None" -o yaml --dry-run > /tmp/srv.yaml

kubectl create --edit -f /tmp/srv.yaml

该kubectl create service命令为服务创建配置并将其保存到/tmp/srv.yaml。

该kubectl create --edit命令在创建对象之前打开配置文件以进行编辑。

使用配置文件管理Kubernetes对象

可以使用kubectl 命令行工具以及使用YAML或JSON编写的对象配置文件来创建,更新和删除Kubernetes对象。本文档介绍了如何使用配置文件定义和管理对象。

- 权衡

- 如何创建对象

- 如何更新对象

- 如何删除对象

- 如何查看对象

- 限制

- 在不保存配置的情况下从URL创建和编辑对象

- 从命令式命令迁移到命令式对象配置

- 定义控制器选择器和PodTemplate标签

权衡

该kubectl工具支持三种对象管理:

- 命令式命令

- 势在必行的对象配置

- 声明性对象配置

有关每种对象管理 的优缺点的讨论,请参阅Kubernetes对象管理。

如何创建对象

您可以使用kubectl create -f从配置文件创建对象。 有关详细信息,请参阅kubernetes API参考。

kubectl create -f <filename|url>

如何更新对象

警告:使用该

replace命令更新对象会删除配置文件中未指定的规范的所有部分。这不应该与规范部分由集群管理的对象一起使用,例如类型服务LoadBalancer,其中externalIPs字段独立于配置文件进行管理。必须将独立管理的字段复制到配置文件中以防止replace丢弃它们。

您可以使用kubectl replace -f根据配置文件更新活动对象。

kubectl replace -f <filename|url>

如何删除对象

您可以使用kubectl delete -f删除配置文件中描述的对象。

kubectl delete -f <filename|url>

如何查看对象

您可以使用它kubectl get -f来查看有关配置文件中描述的对象的信息。

kubectl get -f <filename|url> -o yaml

该-o yaml标志指定打印完整对象配置。使用kubectl get -h查看选项列表。

限制

create,replace和delete命令工作得很好,当每个对象的配置完全确定并记录在它的配置文件。但是,当更新活动对象并且更新未合并到其配置文件中时,更新将在下次replace 执行时丢失。如果控制器(例如HorizontalPodAutoscaler)直接对活动对象进行更新,则会发生这种情况。这是一个例子:

- 您可以从配置文件创建对象。

- 另一个源通过更改某个字段来更新对象。

- 您从配置文件中替换该对象。步骤2中其他来源所做的更改将丢失。

如果需要支持同一对象的多个编写器,则可以使用它kubectl apply来管理对象。

在不保存配置的情况下从URL创建和编辑对象

假设您具有对象配置文件的URL。您可以 kubectl create --edit在创建对象之前用于更改配置。这对于指向可由读者修改的配置文件的教程和任务特别有用。

1 | kubectl create -f <url> --edit |

从命令式命令迁移到命令式对象配置

- 从命令式命令迁移到命令式对象配置涉及几个手动步骤。

将活动对象导出到本地对象配置文件:

1 | kubectl get <kind>/<name> -o yaml --export > <kind>_<name>.yaml |

从对象配置文件中手动删除状态字段。

对于后续对象管理,请

replace专门使用。

1 | kubectl replace -f <kind>_<name>.yaml |

定义控制器选择器和PodTemplate标签

警告:强烈建议不要更新控制器上的选择器。

推荐的方法是定义一个仅由控制器选择器使用的单个不可变PodTemplate标签,没有其他语义含义。

示例标签:1

2

3

4

5

6

7selector:

matchLabels:

controller-selector: "extensions/v1beta1/deployment/nginx"

template:

metadata:

labels:

controller-selector: "extensions/v1beta1/deployment/nginx"

使用配置文件声明管理Kubernetes对象

可以通过在目录中存储多个对象配置文件并使用kubectl apply根据需要递归创建和更新这些对象来创建,更新和删除Kubernetes对象。此方法保留对活动对象的写入,而不将更改合并回对象配置文件。kubectl diff还可以预览apply将要进行的更改。

- 权衡

- 在你开始之前

- 如何创建对象

- 如何更新对象

- 如何删除对象

- 如何查看对象

- 如何应用计算差异并合并更改

- 默认字段值

- 如何更改配置文件和直接命令式编写器之间字段的所有权

- 改变管理方法

- 定义控制器选择器和PodTemplate标签

权衡

该kubectl工具支持三种对象管理:

- 命令式命令

- 势在必行的对象配置

- 声明性对象配置

有关每种对象管理 的优缺点的讨论,请参阅Kubernetes对象管理。

在你开始之前

声明性对象配置需要牢固地理解Kubernetes对象定义和配置。如果您还没有阅读并填写以下文件:

以下是本文档中使用的术语的定义:

- 对象配置文件/配置文件:定义Kubernetes对象配置的文件。本主题说明如何将配置文件传递给

kubectl apply。配置文件通常存储在源代码管理中,例如Git。 - 实时对象配置/实时配置:Kubernetes集群观察到的对象的实时配置值。这些保存在Kubernetes集群存储中,通常是etcd。

- 声明性配置writer / declarative writer:对活动对象进行更新的人员或软件组件。本主题中提到的实时编写器会更改对象配置文件并运行

kubectl apply以编写更改。

如何创建对象

使用kubectl apply创建的所有对象,除了那些已经存在,通过配置文件在指定的目录中定义:1

kubectl apply -f <directory>/

这将kubectl.kubernetes.io/last-applied-configuration: '{...}'在每个对象上设置注释。注释包含用于创建对象的对象配置文件的内容。

注意:添加-R标志以递归处理目录。

以下是对象配置文件的示例:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20#application/simple_deployment.yaml

apiVersion: apps/v1

kind: Deployment

metadata:

name: nginx-deployment

spec:

selector:

matchLabels:

app: nginx

minReadySeconds: 5

template:

metadata:

labels:

app: nginx

spec:

containers:

- name: nginx

image: nginx:1.7.9

ports:

- containerPort: 80

运行kubectl diff以打印将要创建的对象:1

kubectl diff -f https://k8s.io/examples/application/simple_deployment.yaml

注意:

diff使用服务器端干运行,需要启用kube-apiserver。

使用kubectl apply以下方法创建对象1

kubectl apply -f https://k8s.io/examples/application/simple_deployment.yaml

使用kubectl get以下方式打印实时配置1

kubectl get -f https://k8s.io/examples/application/simple_deployment.yaml -o yaml

输出显示kubectl.kubernetes.io/last-applied-configuration注释已写入实时配置,并且与配置文件匹配:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36kind: Deployment

metadata:

annotations:

kubectl.kubernetes.io/last-applied-configuration: |

{"apiVersion":"apps/v1","kind":"Deployment",

"metadata":{"annotations":{},"name":"nginx-deployment","namespace":"default"},

"spec":{"minReadySeconds":5,"selector":{"matchLabels":{"app":nginx}},"template":{"metadata":{"labels":{"app":"nginx"}},

"spec":{"containers":[{"image":"nginx:1.7.9","name":"nginx",

"ports":[{"containerPort":80}]}]}}}}

spec:

minReadySeconds: 5

selector:

matchLabels:

app: nginx

template:

metadata:

labels:

app: nginx

spec:

containers:

- image: nginx:1.7.9

name: nginx

ports:

- containerPort: 80

如何更新对象

您还可以使用kubectl apply更新目录中定义的所有对象,即使这些对象已存在。此方法可实现以下目标:

- 设置实时配置中配置文件中显示的字段。

- 清除实时配置中从配置文件中删除的字段。

1 | kubectl diff -f <directory>/ |

注意:添加-R标志以递归处理目录。

这是一个示例配置文件:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20#application/simple_deployment.yaml

apiVersion: apps/v1

kind: Deployment

metadata:

name: nginx-deployment

spec:

selector:

matchLabels:

app: nginx

minReadySeconds: 5

template:

metadata:

labels:

app: nginx

spec:

containers:

- name: nginx

image: nginx:1.7.9

ports:

- containerPort: 80

使用kubectl apply以下方法创建对象1

kubectl apply -f https://k8s.io/examples/application/simple_deployment.yaml

注意:出于说明的目的,上述命令引用单个配置文件而不是目录。

使用kubectl get以下方式打印实时配置1

kubectl get -f https://k8s.io/examples/application/simple_deployment.yaml -o yaml

输出显示kubectl.kubernetes.io/last-applied-configuration注释已写入实时配置,并且与配置文件匹配:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36kind: Deployment

metadata:

annotations:

kubectl.kubernetes.io/last-applied-configuration: |

{"apiVersion":"apps/v1","kind":"Deployment",

"metadata":{"annotations":{},"name":"nginx-deployment","namespace":"default"},

"spec":{"minReadySeconds":5,"selector":{"matchLabels":{"app":nginx}},"template":{"metadata":{"labels":{"app":"nginx"}},

"spec":{"containers":[{"image":"nginx:1.7.9","name":"nginx",

"ports":[{"containerPort":80}]}]}}}}

spec:

minReadySeconds: 5

selector:

matchLabels:

app: nginx

template:

metadata:

labels:

app: nginx

spec:

containers:

- image: nginx:1.7.9

name: nginx

ports:

- containerPort: 80

使用,直接更新replicas实时配置中的字段kubectl scale。这不使用kubectl apply:1

kubectl scale deployment/nginx-deployment --replicas=2

使用kubectl get以下方式打印实时配置1

kubectl get -f https://k8s.io/examples/application/simple_deployment.yaml -o yaml

输出显示该replicas字段已设置为2,并且last-applied-configuration注释不包含replicas字段:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35apiVersion: apps/v1

kind: Deployment

metadata:

annotations:

kubectl.kubernetes.io/last-applied-configuration: |

{"apiVersion":"apps/v1","kind":"Deployment",

"metadata":{"annotations":{},"name":"nginx-deployment","namespace":"default"},

"spec":{"minReadySeconds":5,"selector":{"matchLabels":{"app":nginx}},"template":{"metadata":{"labels":{"app":"nginx"}},

"spec":{"containers":[{"image":"nginx:1.7.9","name":"nginx",

"ports":[{"containerPort":80}]}]}}}}

spec:

replicas: 2

minReadySeconds: 5

selector:

matchLabels:

app: nginx

template:

metadata:

labels:

app: nginx

spec:

containers:

- image: nginx:1.7.9

name: nginx

ports:

- containerPort: 80

更新simple_deployment.yaml配置文件以将映像更改 nginx:1.7.9为nginx:1.11.9,并删除该minReadySeconds字段:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19#application/update_deployment.yaml

apiVersion: apps/v1

kind: Deployment

metadata:

name: nginx-deployment

spec:

selector:

matchLabels:

app: nginx

template:

metadata:

labels:

app: nginx

spec:

containers:

- name: nginx

image: nginx:1.11.9 # update the image

ports:

- containerPort: 80

应用对配置文件所做的更改:1

2kubectl diff -f https://k8s.io/examples/application/update_deployment.yaml

kubectl apply -f https://k8s.io/examples/application/update_deployment.yaml

使用kubectl get以下方式打印实时配置1

kubectl get -f https://k8s.io/examples/application/simple_deployment.yaml -o yaml

输出显示实时配置的以下更改:

该replicas字段保留2的值kubectl scale。这是可能的,因为它从配置文件中省略。

该image场已被更新,以nginx:1.11.9从nginx:1.7.9。

该last-applied-configuration批注已经更新了新的形象。

该minReadySeconds领域已被清除。

该last-applied-configuration注释不再包含minReadySeconds字段。

1 | apiVersion: apps/v1 |

警告:混合

kubectl apply与势在必行对象配置命令create和replace不支持。这是因为create并replace没有保留kubectl.kubernetes.io/last-applied-configuration的是kubectl apply用来计算更新。

如何删除对象

删除管理对象有两种方法kubectl apply。

推荐的: kubectl delete -f <filename>

建议的方法是使用命令式命令手动删除对象,因为它更明确地删除了什么,并且不太可能导致用户无意中删除了某些内容1

kubectl delete -f <filename>

替代方案: kubectl apply -f <directory/> --prune -l your=label

只有在你知道自己在做什么的情况下才能使用它。

警告:

kubectl apply --prune处于alpha状态,后续版本中可能会引入向后不兼容的更改。

警告:使用此命令时必须小心,以免意外删除对象。

作为替代方法kubectl delete,您可以使用它kubectl apply来识别从目录中删除配置文件后要删除的对象。--prune 对API服务器应用查询以匹配一组标签的所有对象,并尝试将返回的活动对象配置与对象配置文件进行匹配。如果对象与查询匹配,并且目录中没有配置文件,并且它具有last-applied-configuration注释,则会将其删除。1

kubectl apply -f <directory/> --prune -l <labels>

警告:只应对包含对象配置文件的根目录运行prune。如果对象被指定的标签选择器查询返回-l

并且未出现在子目录中,则对子目录运行会导致无意中删除对象。

如何查看对象

您可以使用kubectl getwith -o yaml来查看活动对象的配置:

1 | kubectl get -f <filename|url> -o yaml |

如何应用计算差异并合并更改

注意:补丁是一种更新操作,其范围限定为对象的特定字段而不是整个对象。这样可以仅更新对象上的特定字段集,而无需先读取对象。

当kubectl apply一个对象更新实时配置,它通过发送补丁请求API服务器这样做。该补丁定义了作用于活动对象配置的特定字段的更新。该kubectl apply命令使用配置文件,实时配置和实时配置中last-applied-configuration存储的注释来计算此修补程序请求 。

合并补丁计算

该kubectl apply命令将配置文件的内容写入 kubectl.kubernetes.io/last-applied-configuration注释。这用于标识已从配置文件中删除的字段,需要从实时配置中清除。以下是用于计算应删除或设置哪些字段的步骤:

- 计算要删除的字段。这些是

last-applied-configuration配置文件中存在和丢失的字段。 - 计算要添加或设置的字段。这些是配置文件中存在的字段,其值与实时配置不匹配。

这是一个例子。假设这是Deployment对象的配置文件:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19#application/update_deployment.yaml

apiVersion: apps/v1

kind: Deployment

metadata:

name: nginx-deployment

spec:

selector:

matchLabels:

app: nginx

template:

metadata:

labels:

app: nginx

spec:

containers:

- name: nginx

image: nginx:1.11.9 # update the image

ports:

- containerPort: 80

另外,假设这是同一Deployment对象的实时配置:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35apiVersion: apps/v1

kind: Deployment

metadata:

annotations:

kubectl.kubernetes.io/last-applied-configuration: |

{"apiVersion":"apps/v1","kind":"Deployment",

"metadata":{"annotations":{},"name":"nginx-deployment","namespace":"default"},

"spec":{"minReadySeconds":5,"selector":{"matchLabels":{"app":nginx}},"template":{"metadata":{"labels":{"app":"nginx"}},

"spec":{"containers":[{"image":"nginx:1.7.9","name":"nginx",

"ports":[{"containerPort":80}]}]}}}}

spec:

replicas: 2

minReadySeconds: 5

selector:

matchLabels:

app: nginx

template:

metadata:

labels:

app: nginx

spec:

containers:

- image: nginx:1.7.9

name: nginx

ports:

- containerPort: 80

以下是将通过以下方式执行的合并计算kubectl apply:

- 通过读取值

last-applied-configuration并将它们与配置文件中的值进行比较来计算要删除的字段 。清除字段在本地对象配置文件中显式设置为null,无论它们是否出现在last-applied-configuration。在此示例中,minReadySeconds出现在last-applied-configuration注释中,但未出现在配置文件中。 Action:minReadySeconds`从实时配置中清除。 - 通过从配置文件中读取值并将它们与实时配置中的值进行比较来计算要设置的字段。在此示例中,

image配置文件中的值与实时配置中的值不匹配。Action:设置image实时配置中的值。 - 设置

last-applied-configuration注释以匹配配置文件的值。 - 将来自1,2,3的结果合并到API服务器的单个补丁请求中。

以下是合并的实时配置:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38apiVersion: apps/v1

kind: Deployment

metadata:

annotations:

# ...

# The annotation contains the updated image to nginx 1.11.9,

# but does not contain the updated replicas to 2

kubectl.kubernetes.io/last-applied-configuration: |

{"apiVersion":"apps/v1","kind":"Deployment",

"metadata":{"annotations":{},"name":"nginx-deployment","namespace":"default"},

"spec":{"selector":{"matchLabels":{"app":nginx}},"template":{"metadata":{"labels":{"app":"nginx"}},

"spec":{"containers":[{"image":"nginx:1.11.9","name":"nginx",

"ports":[{"containerPort":80}]}]}}}}

# ...

spec:

selector:

matchLabels:

# ...

app: nginx

replicas: 2 # Set by `kubectl scale`. Ignored by `kubectl apply`.

# minReadySeconds cleared by `kubectl apply`

# ...

template:

metadata:

# ...

labels:

app: nginx

spec:

containers:

- image: nginx:1.11.9 # Set by `kubectl apply`

# ...

name: nginx

ports:

- containerPort: 80

# ...

# ...

# ...

# ...

如何合并不同类型的字段

配置文件中的特定字段如何与实时配置合并取决于字段的类型。有几种类型的字段:

- primitive:字符串,整数或布尔类型的字段。例如,

image和replicas是原始字段。行动:替换。 - map,也称为object:类型为map的字段或包含子字段的复杂类型。例如

labels,annotations,spec并且metadata是所有map。Action:合并元素或子字段。 - list:包含可以是基本类型或映射的项列表的字段。例如

containers,ports和args是列表。行动:变化。

当kubectl apply更新map或列表字段,它通常不更换整个领域,而是更新各个子元素。例如,在合并spec部署时,spec不会替换整个部署。相反,比较和合并spec诸如的子字段replicas。

将更改合并到基本字段

将更改合并到基本字段

注意: -用于“不适用”,因为未使用该值。

| 对象配置文件中的字段 | 实时对象配置中的字段 | 最后应用配置中的字段 | 行动 |

|---|---|---|---|

| 是 | 是 | - | 设置为配置文件值。 |

| 是 | 没有 | - | 将实时设置为本地配置。 |

| 没有 | - | - | 从实时配置中清除。 |

| 没有 | - | 没有 | 没做什么。保持实时价值。 |

合并对地图字段的更改

通过比较地图的每个子字段或元素来合并表示地图的字段:

注意: -用于“不适用”,因为未使用该值。

| 键入对象配置文件 | 键入实时对象配置 | 最后应用配置中的字段 | 行动 |

|---|---|---|---|

| 是 | 是 | - | 比较子字段值。 |

| 是 | 没有 | - | 将实时设置为本地配置。 |

| 没有 | - | 是 | 从实时配置中删除。 |

| 没有 | - | 没有 | 没做什么。保持实时价值。 |

合并类型列表字段的更改

将更改合并到列表使用以下三种策略之一:

- 替换列表。

- 合并复杂元素列表中的各个元素。

- 合并原始元素列表。

战略的选择是基于每个领域。

替换列表

将列表视为与原始字段相同。替换或删除整个列表。这保留了订购。

例如:使用kubectl apply更新args一个pod里的一个Container的field。这会将args实时配置中的值设置为配置文件中的值。args之前已添加到实时配置的任何元素都将丢失。args配置文件中定义的元素的顺序将保留在实时配置中。1

2

3

4

5

6

7

8

9

10

11

args: ["a", "b"]

args: ["a", "c"]

args: ["a", "b", "d"]

args: ["a", "c"]

说明:合并使用配置文件值作为新列表值。

合并复杂元素列表中的各个元素:

将列表视为映射,并将每个元素的特定字段视为键。添加,删除或更新单个元素。这不会保留排序。

此合并策略在每个字段上使用一个名为a的特殊标记patchMergeKey。patchMergeKey是在Kubernetes源代码中的每个字段中定义: types.go 当合并映射的列表,指定的字段作为patchMergeKey对于给定的元素被用于像该元素的映射键。

例如:使用kubectl apply更新containers一PodSpec的field。这将列表合并为好像是每个元素都被键入的映射name。1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42# last-applied-configuration value

containers:

- name: nginx

image: nginx:1.10

- name: nginx-helper-a # key: nginx-helper-a; will be deleted in result

image: helper:1.3

- name: nginx-helper-b # key: nginx-helper-b; will be retained

image: helper:1.3

# configuration file value

containers:

- name: nginx

image: nginx:1.10

- name: nginx-helper-b

image: helper:1.3

- name: nginx-helper-c # key: nginx-helper-c; will be added in result

image: helper:1.3

# live configuration

containers:

- name: nginx

image: nginx:1.10

- name: nginx-helper-a

image: helper:1.3

- name: nginx-helper-b

image: helper:1.3

args: ["run"] # Field will be retained

- name: nginx-helper-d # key: nginx-helper-d; will be retained

image: helper:1.3

# result after merge

containers:

- name: nginx

image: nginx:1.10

# Element nginx-helper-a was deleted

- name: nginx-helper-b

image: helper:1.3

args: ["run"] # Field was retained

- name: nginx-helper-c # Element was added

image: helper:1.3

- name: nginx-helper-d # Element was ignored

image: helper:1.3

说明:

- 名为“nginx-helper-a”的容器已删除,因为配置文件中没有出现名为“nginx-helper-a”的容器。

- 名为“nginx-helper-b”的容器保留

args了实时配置中的更改。kubectl apply能够识别实时配置中的“nginx-helper-b”与配置文件中的“nginx-helper-b”相同,即使它们的字段具有不同的值(args配置文件中没有)。这是因为patchMergeKey字段值(名称)在两者中都是相同的。 - 添加了名为“nginx-helper-c”的容器,因为实时配置中没有出现具有该名称的容器,但配置文件中出现了具有该名称的容器。

- 保留名为“nginx-helper-d”的容器,因为在最后应用的配置中没有出现具有该名称的元素。

合并原始元素列表

从Kubernetes 1.5开始,不支持合并原始元素列表。

注意:为给定字段选择的上述策略中的哪一个由types.go中的

patchStrategy标记控制。如果没有为类型列表的字段指定patchStrategy,则替换列表。

默认字段值

如果在创建对象时未指定某些字段,则API服务器会将某些字段设置为实时配置中的默认值。

这是部署的配置文件。该文件未指定strategy:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20#application/simple_deployment.yaml

apiVersion: apps/v1

kind: Deployment

metadata:

name: nginx-deployment

spec:

selector:

matchLabels:

app: nginx

minReadySeconds: 5

template:

metadata:

labels:

app: nginx

spec:

containers:

- name: nginx

image: nginx:1.7.9

ports:

- containerPort: 80

使用kubectl apply以下方法创建对象1

kubectl apply -f https://k8s.io/examples/application/simple_deployment.yaml

使用kubectl get以下方式打印实时配置1

kubectl get -f https://k8s.io/examples/application/simple_deployment.yaml -o yaml

输出显示API服务器在实时配置中将多个字段设置为默认值。配置文件中未指定这些字段。1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34apiVersion: apps/v1

kind: Deployment

# ...

spec:

selector:

matchLabels:

app: nginx

minReadySeconds: 5

replicas: 1 # defaulted by apiserver

strategy:

rollingUpdate: # defaulted by apiserver - derived from strategy.type

maxSurge: 1

maxUnavailable: 1

type: RollingUpdate # defaulted apiserver

template:

metadata:

creationTimestamp: null

labels:

app: nginx

spec:

containers:

- image: nginx:1.7.9

imagePullPolicy: IfNotPresent # defaulted by apiserver

name: nginx

ports:

- containerPort: 80

protocol: TCP # defaulted by apiserver

resources: {} # defaulted by apiserver

terminationMessagePath: /dev/termination-log # defaulted by apiserver

dnsPolicy: ClusterFirst # defaulted by apiserver

restartPolicy: Always # defaulted by apiserver

securityContext: {} # defaulted by apiserver

terminationGracePeriodSeconds: 30 # defaulted by apiserver

# ...

在修补程序请求中,默认字段不会被重新默认,除非它们作为修补程序请求的一部分被明确清除。这可能会导致基于其他字段的值默认的字段出现意外行为。稍后更改其他字段时,除非明确清除,否则不会更新默认值。

因此,建议在配置文件中显式定义服务器默认的某些字段,即使所需的值与服务器默认值匹配也是如此。这样可以更轻松地识别不会被服务器重新默认的冲突值。

例:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63# last-applied-configuration

spec:

template:

metadata:

labels:

app: nginx

spec:

containers:

- name: nginx

image: nginx:1.7.9

ports:

- containerPort: 80

# configuration file

spec:

strategy:

type: Recreate # updated value

template:

metadata:

labels:

app: nginx

spec:

containers:

- name: nginx

image: nginx:1.7.9

ports:

- containerPort: 80

# live configuration

spec:

strategy:

type: RollingUpdate # defaulted value

rollingUpdate: # defaulted value derived from type

maxSurge : 1

maxUnavailable: 1

template:

metadata:

labels:

app: nginx

spec:

containers:

- name: nginx

image: nginx:1.7.9

ports:

- containerPort: 80

# result after merge - ERROR!

spec:

strategy:

type: Recreate # updated value: incompatible with rollingUpdate

rollingUpdate: # defaulted value: incompatible with "type: Recreate"

maxSurge : 1

maxUnavailable: 1

template:

metadata:

labels:

app: nginx

spec:

containers:

- name: nginx

image: nginx:1.7.9

ports:

- containerPort: 80

说明:

- 用户无需定义即可创建部署

strategy.type。 - 服务器默认

strategy.type为RollingUpdate默认strategy.rollingUpdate值。 - 用户更改

strategy.type为Recreate。该strategy.rollingUpdate值保持在其默认的值,但服务器期望他们被清除。如果strategy.rollingUpdate最初在配置文件中定义了值,则更清楚的是它们需要被删除。 - 应用失败,因为

strategy.rollingUpdate未清除。该strategy.rollingupdate字段不能与被定义strategy.type的Recreate。

建议:应在对象配置文件中明确定义这些字段:

- 工作负载上的选择器和PodTemplate标签,例如Deployment,StatefulSet,Job,DaemonSet,ReplicaSet和ReplicationController

- 部署部署策略

如何清除其他编写者设置的服务器默认字段或字段

可以通过将其值设置为null然后应用配置文件来清除未出现在配置文件中的字段。对于服务器默认的字段,这会触发重新默认值。

如何更改配置文件和直接命令式编写器之间字段的所有权

这些是您应该用来更改单个对象字段的唯一方法:

- 使用

kubectl apply。 - 直接写入实时配置而不修改配置文件:例如,使用

kubectl scale。

将所有者从直接命令式编写器更改为配置文件

将该字段添加到配置文件中。对于现场,停止对未经过的实时配置的直接更新kubectl apply。

将所有者从配置文件更改为直接命令式编写器

从Kubernetes 1.5开始,将字段的所有权从配置文件更改为命令式编写器需要手动步骤:

- 从配置文件中删除该字段。

- 从

kubectl.kubernetes.io/last-applied-configuration活动对象上的注释中删除该字段。

改变管理方法

应该一次只使用一种方法管理Kubernetes对象。可以从一种方法切换到另一种方法,但这是一种手动过程。

注意:使用命令式删除和声明式管理是可以的。

从命令式命令管理迁移到声明性对象配置

从命令式命令管理迁移到声明性对象配置涉及几个手动步骤:

将活动对象导出到本地配置文件:

1

kubectl get <kind>/<name> -o yaml --export > <kind>_<name>.yaml

status从配置文件中手动删除该字段。

注意:此步骤是可选的,因为

kubectl apply不会更新状态字段 即使它存在于配置文件中。

kubectl.kubernetes.io/last-applied-configuration在对象上设置注释:1

kubectl replace --save-config -f <kind>_<name>.yaml

更改

kubectl apply用于专门管理对象的进程。

从命令式对象配置迁移到声明性对象配置

kubectl.kubernetes.io/last-applied-configuration在对象上设置注释:1

kubectl replace --save-config -f <kind>_<name>.yaml

更改

kubectl apply用于专门管理对象的进程。

定义控制器选择器和PodTemplate标签

警告:强烈建议不要更新控制器上的选择器。

推荐的方法是定义一个仅由控制器选择器使用的单个不可变PodTemplate标签,没有其他语义含义。

例:1

2

3

4

5

6

7selector:

matchLabels:

controller-selector: "extensions/v1beta1/deployment/nginx"

template:

metadata:

labels:

controller-selector: "extensions/v1beta1/deployment/nginx"

Kubernetes Architecture

节点

节点是Kubernetes中的工作机器,以前称为一个 minion。节点可以是VM或物理机,具体取决于集群。每个节点都包含运行pods所需的服务,并由主组件管理。节点上的服务包括container runtime,kubelet和kube-proxy。有关更多详细信息,请参阅 体系结构设计文档中的Kubernetes节点部分。

- 节点状态

- 管理

- API对象

节点状态

节点的状态包含以下信息:

- 地址

- 条件

- 容量

- 信息

下面详细描述每个部分。

地址

这些字段的使用取决于您的云提供商或裸机配置。

- HostName:节点内核报告的主机名。可以通过kubelet

--hostname-override参数覆盖。 - ExternalIP:通常是可从外部路由的节点的IP地址(可从群集外部获得)。

- InternalIP:通常仅在群集内可路由的节点的IP地址。

条件

该conditions字段描述了所有Running节点的状态。

| 节点条件 | 描述 |

|---|---|

OutOfDisk |

True 如果节点上的可用空间不足以添加新的pod,否则 False |

Ready |

True如果节点是健康的并准备好接受pod,False如果节点不健康且不接受pod,并且Unknown节点控制器在最后一次没有从节点听到node-monitor-grace-period(默认为40秒) |

MemoryPressure |

True如果节点存储器上存在压力 - 即节点存储器是否为低; 除此以外False |

PIDPressure |

True如果进程存在压力 - 也就是说,如果节点上有太多进程; 除此以外False |

DiskPressure |

True如果磁盘大小存在压力 - 即磁盘容量低; 除此以外False |

NetworkUnavailable |

True 如果没有正确配置节点的网络,否则 False |

节点条件表示为JSON对象。例如,以下响应描述了健康节点。1

2

3

4

5

6"conditions": [

{

"type": "Ready",

"status": "True"

}

]

如果就绪状态的状态保持Unknown或False超过pod-eviction-timeout,则会将参数传递给kube-controller-manager,并且节点控制器会调度节点上的所有Pod以进行删除。默认逐出超时持续时间为五分钟。在某些情况下,当节点无法访问时,apiserver无法与节点上的kubelet通信。在重新建立与apiserver的通信之前,不能将删除pod的决定传送到kubelet。同时,计划删除的pod可以继续在分区节点上运行。

在1.5之前的Kubernetes版本中,节点控制器会从apiserver中强制删除这些无法访问的pod。但是,在1.5及更高版本中,节点控制器不会强制删除容器,直到确认它们已停止在群集中运行。您可以看到可能在无法访问的节点上运行的Pod处于Terminating或Unknown状态。如果节点永久离开群集,如果Kubernetes无法从底层基础架构推断出,则群集管理员可能需要手动删除节点对象。从Kubernetes中删除节点对象会导致节点上运行的所有Pod对象从apiserver中删除,并释放它们的名称。

在版本1.12中,TaintNodesByCondition功能被提升为beta版,因此节点生命周期控制器会自动创建表示条件的 taints 。类似地,调度程序在考虑节点时忽略条件;相反,它会查看Node的污点和Pod的容忍度。 现在,用户可以在旧的调度模型和更灵活的新调度模型之间进行选择。根据旧型号,可以安排没有任何容忍度的Pod。但是可以在该节点上安排容忍特定节点的污点的Pod。

警告:启用此功能会在观察到条件和创建污点之间产生一个小延迟。此延迟通常小于一秒,但它可以增加成功安排但被kubelet拒绝的Pod的数量。

容量

描述节点上可用的资源:CPU,内存以及可以在节点上调度的最大pod数。

信息

有关节点的一般信息,例如内核版本,Kubernetes版本(kubelet和kube-proxy版本),Docker版本(如果使用),操作系统名称。信息由Kubelet从节点收集。

管理

与pod和服务不同,Kubernetes本身并不创建节点:它由Google Compute Engine等云提供商在外部创建,或者存在于物理或虚拟机池中。因此,当Kubernetes创建节点时,它会创建一个表示节点的对象。创建后,Kubernetes会检查节点是否有效。例如,如果您尝试从以下内容创建节点:1

2

3

4

5

6

7

8

9

10{

"kind": "Node",

"apiVersion": "v1",

"metadata": {

"name": "10.240.79.157",

"labels": {

"name": "my-first-k8s-node"

}

}

}

Kubernetes在内部创建节点对象(表示),并通过基于metadata.name字段的运行状况检查来验证节点。如果节点有效 - 即,如果所有必需的服务都在运行 - 它有资格运行pod。否则,对于任何群集活动,它将被忽略,直到它变为有效。

注意: Kubernetes保留无效节点的对象,并不断检查它是否有效。您必须显式删除Node对象才能停止此过程。

目前,有三个组件与Kubernetes节点接口交互:节点控制器,kubelet和kubectl。

节点控制器

节点控制器是Kubernetes主组件,它管理节点的各个方面。

节点控制器在节点的生命周期中具有多个角色。第一种是在注册时为节点分配CIDR块(如果打开了CIDR分配)。

第二个是使节点控制器的内部节点列表与云提供商的可用计算机列表保持同步。在云环境中运行时,只要节点不健康,节点控制器就会询问云提供商该节点的VM是否仍然可用。如果不是,则节点控制器从其节点列表中删除该节点。

第三是监测节点的健康状况。节点控制器负责在节点变得无法访问时将NodeStatus的NodeReady条件更新为ConditionUnknown(即节点控制器由于某种原因停止接收心跳,例如由于节点关闭),然后从节点中驱逐所有pod (如果节点仍然无法访问,则使用正常终止)。(默认超时为40 --node-monitor-period秒,开始报告ConditionUnknown,之后5米开始驱逐pod。)节点控制器每秒检查每个节点的状态。

在1.13之前的Kubernetes版本中,NodeStatus是节点的心跳。从Kubernetes 1.13开始,节点租用功能作为alpha功能引入(功能门NodeLease, KEP-0009)。启用节点租用功能时,每个节点都有一个关联的Lease对象 kube-node-lease由节点定期更新的命名空间,NodeStatus和节点租约都被视为来自节点的心跳。节点租约经常更新,而NodeStatus仅在有一些更改或经过足够时间时从节点报告为主节点(默认值为1分钟,这比不可达节点的默认超时40秒)。由于节点租约比NodeStatus轻得多,因此从可伸缩性和性能角度来看,此功能使节点心跳显着降低。

在Kubernetes 1.4中,我们更新了节点控制器的逻辑,以便在大量节点到达主站时遇到问题时更好地处理案例(例如,因为主站有网络问题)。从1.4开始,节点控制器在决定pod驱逐时查看集群中所有节点的状态。

在大多数情况下,节点控制器将驱逐率限制为每秒 --node-eviction-rate(默认值0.1),这意味着它不会每10秒从多个节点驱逐pod。

当给定可用区中的节点变得不健康时,节点逐出行为会发生变化。节点控制器同时检查区域中节点的百分比是否不健康(NodeReady条件是ConditionUnknown或ConditionFalse)。如果不健康节点的比例至少为 --unhealthy-zone-threshold(默认为0.55),则驱逐率降低:如果群集较小(即小于或等于--large-cluster-size-threshold节点 - 默认为50)则停止驱逐,否则驱逐率降低为 --secondary-node-eviction-rate(默认0.01)每秒。每个可用区域实施这些策略的原因是因为一个可用区域可能从主服务器分区而其他可用区域保持连接。如果您的群集未跨越多个云提供商可用区域,则只有一个可用区域(整个群集)。

在可用区域之间传播节点的一个关键原因是,当整个区域出现故障时,工作负载可以转移到健康区域。因此,如果区域中的所有节点都不健康,则节点控制器以正常速率驱逐--node-eviction-rate。角落情况是所有区域完全不健康(即群集中没有健康的节点)。在这种情况下,节点控制器假定主连接存在一些问题,并在某些连接恢复之前停止所有驱逐。

从Kubernetes 1.6开始,NodeController还负责驱逐在具有NoExecute污点的节点上运行的pod,当pod不能容忍taints时。此外,作为默认禁用的alpha功能,NodeController负责添加与节点无法访问或未就绪等节点问题相对应的污点。 有关污点和alpha功能的详细信息,请参阅此文档NoExecute。

从版本1.8开始,节点控制器可以负责创建表示节点条件的污点。这是1.8版的alpha功能。

节点自注册

当kubelet标志--register-node为true(默认值)时,kubelet将尝试向API服务器注册自己。这是大多数发行版使用的首选模式。

对于自行注册,可以使用以下选项启动kubelet:

--kubeconfig- 凭证路径,以向apiserver验证自身。--cloud-provider- 如何与云提供商交谈以阅读有关自身的元数据。--register-node- 自动注册API服务器。--register-with-taints- 使用给定的taints列表注册节点(以逗号分隔<key>=<value>:<effect>)。No-op如果register-node是假的。--node-ip- 节点的IP地址。--node-labels- 在群集中注册节点时添加的标签(请参阅1.13+中NodeRestriction准入插件强制执行的标签限制)。--node-status-update-frequency- 指定kubelet将节点状态发布到master的频率。

当节点授权模式和 NodeRestriction录取插件的启用,kubelets仅被授权创建/修改自己的节点资源。

手动节点管理

集群管理员可以创建和修改节点对象。

如果管理员希望手动创建节点对象,请设置kubelet标志 --register-node=false。

管理员可以修改节点资源(无论设置如何--register-node)。修改包括在节点上设置标签并将其标记为不可调度。

节点上的标签可以与pod上的节点选择器结合使用以控制调度,例如,将pod限制为仅有资格在节点的子集上运行。

将节点标记为不可调度可防止将新pod调度到该节点,但不会影响节点上的任何现有pod。这在节点重启等之前作为准备步骤很有用。例如,要标记节点不可调度,请运行以下命令:1

kubectl cordon $NODENAME

注意:由DaemonSet控制器创建的Pod绕过Kubernetes调度程序,不遵守节点上的不可调度属性。这假设守护进程属于机器,即使它在准备重新启动时正在耗尽应用程序。

节点容量

节点的容量(cpus的数量和内存量)是节点对象的一部分。通常,节点在创建节点对象时注册自己并报告其容量。如果您正在进行手动节点管理,则需要在添加节点时设置节点容量。

Kubernetes调度程序确保节点上的所有pod都有足够的资源。它检查节点上容器请求的总和不大于节点容量。它包括由kubelet启动的所有容器,但不包括由容器运行时直接启动的容器,也不包括在容器外部运行的任何进程。

如果要为非Pod进程显式保留资源,请按照本教程 为系统守护程序保留资源。

API对象

Node是Kubernetes REST API中的顶级资源。有关API对象的更多详细信息,请参见: Node API对象。

主节点通信

本文档对master(实际上是apiserver)和Kubernetes集群之间的通信路径进行了编目。目的是允许用户自定义其安装以强化网络配置,以便群集可以在不受信任的网络(或云提供商上的完全公共IP)上运行。

- 群集到Master

- 掌握群集

群集到Master

从集群到主服务器的所有通信路径都在apiserver处终止(其他主服务器组件均未设计为公开远程服务)。在典型部署中,apiserver被配置为在安全HTTPS端口(443)上侦听远程连接,其中启用了一种或多种形式的客户端认证。 应启用一种或多种授权形式,尤其是 在允许匿名请求 或服务帐户令牌的情况下。

应为节点配置群集的公共根证书,以便它们可以安全地连接到apiserver以及有效的客户端凭据。例如,在默认GKE部署中,提供给kubelet的客户端凭证采用客户端证书的形式。请参阅 kubelet TLS bootstrapping 以自动配置kubelet客户端证书。

希望连接到apiserver的Pod可以通过利用服务帐户安全地执行此操作,以便Kubernetes在实例化时自动将公共根证书和有效的承载令牌注入到pod中。该kubernetes服务(在所有名称空间中)配置有虚拟IP地址,该地址被重定向(通过kube-proxy)到apiserver上的HTTPS端点。

主组件还通过安全端口与群集服务器通信。

因此,默认情况下,从群集(节点和节点上运行的节点)到主节点的连接的默认操作模式是安全的,可以在不受信任和/或公共网络上运行。

掌握群集

从主服务器(apiserver)到集群有两条主要通信路径。第一个是从apiserver到kubelet进程,它在集群中的每个节点上运行。第二种是通过apiserver的代理功能从apiserver到任何节点,pod或服务。

kubelet的保护者

从apiserver到kubelet的连接用于:

- 获取pod的日志。

- 附加(通过kubectl)到运行的pod。

- 提供kubelet的端口转发功能。

这些连接终止于kubelet的HTTPS端点。默认情况下,apiserver不会验证kubelet的服务证书,这会使连接受到中间人攻击,并且 不安全地运行在不受信任的和/或公共网络上。

要验证此连接,请使用该--kubelet-certificate-authority标志为apiserver提供根证书包,以用于验证kubelet的服务证书。

如果无法做到这一点,请 在apiserver和kubelet之间使用SSH隧道,以避免连接不受信任或公共网络。

最后, 应启用Kubelet身份验证和/或授权以保护kubelet API。

节点,pod和服务的apiserver

从apiserver到节点,pod或服务的连接默认为纯HTTP连接,因此既未经过身份验证也未加密。它们可以通过前缀https:到API URL中的节点,pod或服务名称在安全HTTPS连接上运行,但它们不会验证HTTPS端点提供的证书,也不会提供客户端凭据,因此在连接将被加密时,它不会提供任何诚信保证。这些连接目前在不受信任和/或公共网络上运行是不安全的。

云控制器管理器的基础概念

最初创建云控制器管理器(CCM)概念(不要与二进制混淆),以允许特定于云的供应商代码和Kubernetes核心彼此独立地发展。云控制器管理器与其他主组件(如Kubernetes控制器管理器,API服务器和调度程序)一起运行。它也可以作为Kubernetes插件启动,在这种情况下它运行在Kubernetes之上。

云控制器管理器的设计基于一种插件机制,允许新的云提供商通过使用插件轻松地与Kubernetes集成。有计划在Kubernetes上加入新的云提供商,以及将云提供商从旧模型迁移到新的CCM模型。

本文档讨论了云控制器管理器背后的概念,并提供了有关其相关功能的详细信息。

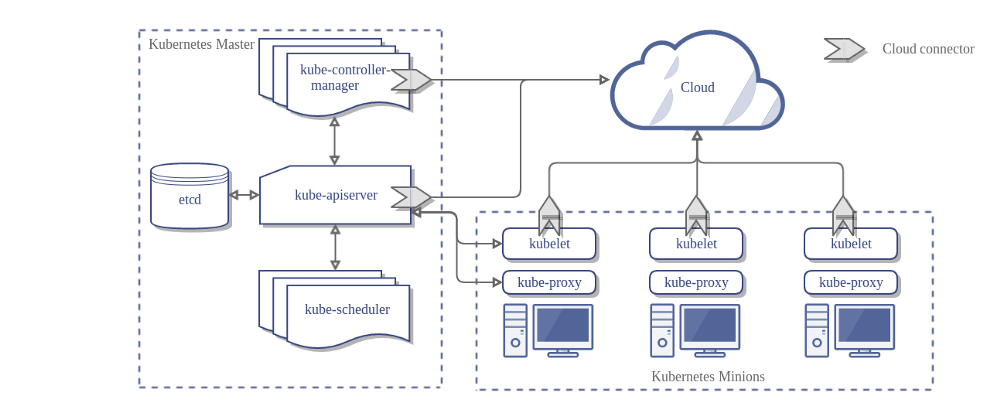

这是没有云控制器管理器的Kubernetes集群的架构:

- 设计

- CCM的组成部分

- CCM的功能

- 插件机制

- 授权

- 供应商实施

- 群集管理

设计

在上图中,Kubernetes和云提供商通过几个不同的组件集成:

- Kubelet

- Kubernetes控制器经理

- Kubernetes API服务器

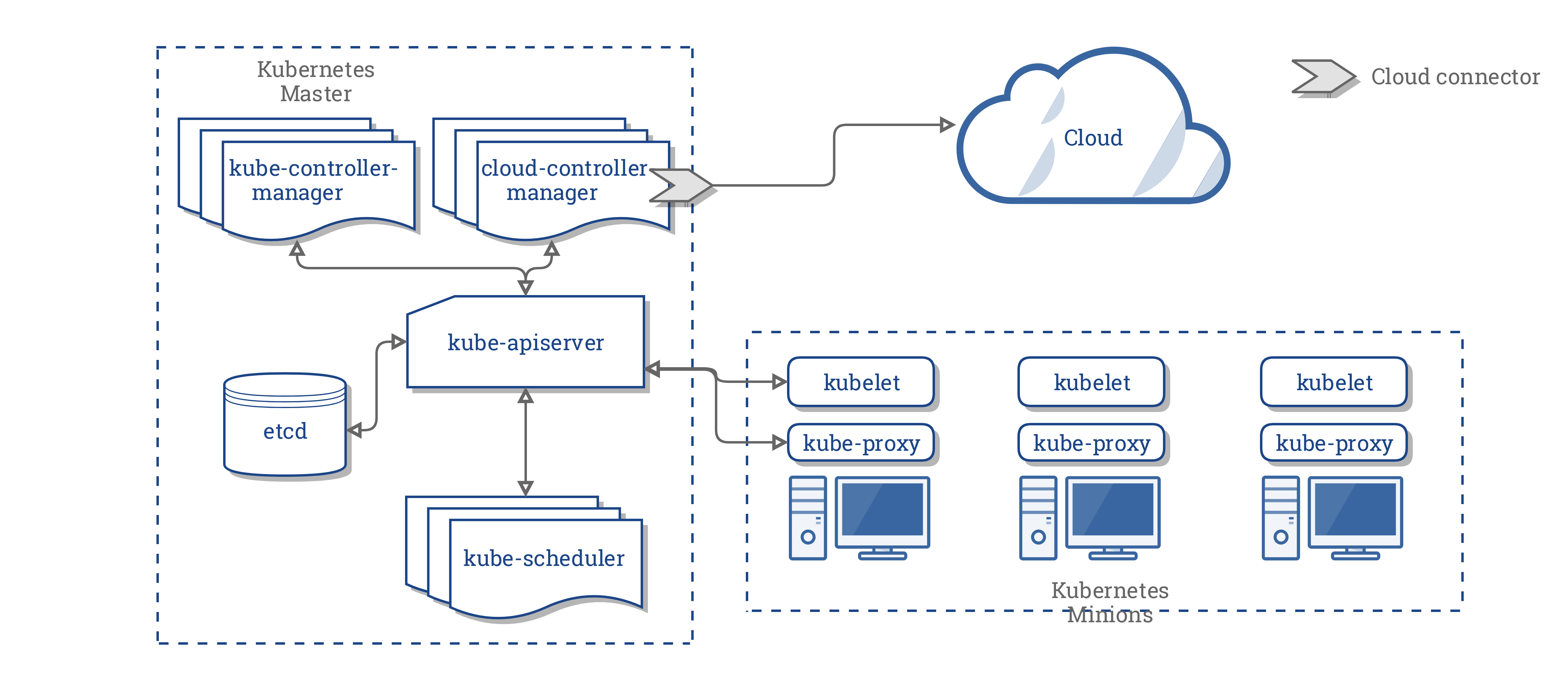

CCM整合了前三个组件中的所有依赖于云的逻辑,以创建与云的单一集成点。CCM的新架构如下所示:

CCM的组成部分

CCM打破了Kubernetes控制器管理器(KCM)的一些功能,并将其作为一个单独的进程运行。具体来说,它打破了KCM中依赖于云的控制器。KCM具有以下依赖于云的控制器循环:

- 节点控制器

- 音量控制器

- 路线控制器

- 服务控制器

在1.9版中,CCM运行前面列表中的以下控制器:

- 节点控制器

- 路线控制器

- 服务控制器

此外,它还运行另一个名为PersistentVolumeLabels控制器的控制器。此控制器负责在GCP和AWS云中创建的PersistentVolumes上设置区域和区域标签。

注意:故意选择音量控制器不属于CCM。由于涉及复杂性并且由于现有的努力抽象出供应商特定的卷逻辑,因此决定不将卷控制器移动到CCM。

使用CCM支持卷的最初计划是使用Flex卷来支持可插拔卷。然而,正在计划一项名为CSI的竞争性工作来取代Flex。

考虑到这些动态,我们决定在CSI准备好之前进行中间止差测量。

CCM的功能

CCM从依赖于云提供商的Kubernetes组件继承其功能。本节基于这些组件构建。

1. Kubernetes控制器经理

CCM的大部分功能来自KCM。如上一节所述,CCM运行以下控制循环:

- 节点控制器

- 路线控制器

- 服务控制器

- PersistentVolumeLabels控制器

节点控制器

节点控制器负责通过从云提供商获取有关在集群中运行的节点的信息来初始化节点。节点控制器执行以下功能:

- 使用特定于云的区域/区域标签初始化节点。

- 使用特定于云的实例详细信息初始化节点,例如,类型和大小。

- 获取节点的网络地址和主机名。

- 如果节点无响应,请检查云以查看该节点是否已从云中删除。如果已从云中删除该节点,请删除Kubernetes Node对象。

路线控制器

Route控制器负责适当地配置云中的路由,以便Kubernetes集群中不同节点上的容器可以相互通信。路径控制器仅适用于Google Compute Engine群集。

服务控制器

服务控制器负责监听服务创建,更新和删除事件。根据Kubernetes中当前的服务状态,它配置云负载均衡器(如ELB或Google LB)以反映Kubernetes中的服务状态。此外,它还确保云负载平衡器的服务后端是最新的。

PersistentVolumeLabels控制器

PersistentVolumeLabels控制器在创建AWS EBS / GCE PD卷时应用标签。这消除了用户手动设置这些卷上的标签的需要。

这些标签对于pod的计划至关重要,因为这些卷仅限于在它们所在的区域/区域内工作。使用这些卷的任何Pod都需要在同一区域/区域中进行调度。

PersistentVolumeLabels控制器专门为CCM创建; 也就是说,在创建CCM之前它不存在。这样做是为了将Kubernetes API服务器(它是一个许可控制器)中的PV标记逻辑移动到CCM。它不在KCM上运行。

2. Kubelet

节点控制器包含kubelet的依赖于云的功能。在引入CCM之前,kubelet负责使用特定于云的详细信息(如IP地址,区域/区域标签和实例类型信息)初始化节点。CCM的引入已将此初始化操作从kubelet转移到CCM。

在这个新模型中,kubelet初始化一个没有特定于云的信息的节点。但是,它会为新创建的节点添加污点,使节点不可调度,直到CCM使用特定于云的信息初始化节点。然后它消除了这种污点。

3. Kubernetes API服务器

PersistentVolumeLabels控制器将Kubernetes API服务器的依赖于云的功能移动到CCM,如前面部分所述。

插件机制

云控制器管理器使用Go接口允许插入任何云的实现。具体来说,它使用此处定义的CloudProvider接口。

上面突出显示的四个共享控制器的实现,以及一些脚手架以及共享的cloudprovider接口,将保留在Kubernetes核心中。特定于云提供商的实现将在核心之外构建,并实现核心中定义的接口。

有关开发插件的更多信息,请参阅开发Cloud Controller Manager。

授权

本节分解了CCM执行其操作时各种API对象所需的访问权限。

节点控制器

Node控制器仅适用于Node对象。它需要完全访问get,list,create,update,patch,watch和delete Node对象。

V1 /节点:

- Get

- List

- Create

- Update

- Patch

- Watch

- Delete

路线控制器

路由控制器侦听Node对象创建并适当地配置路由。它需要访问Node对象。

V1 /节点:

- Get

服务控制器

服务控制器侦听Service对象创建,更新和删除事件,然后适当地为这些服务配置端点。

要访问服务,它需要列表和监视访问权限。要更新服务,它需要修补和更新访问权限。

要为服务设置端点,需要访问create,list,get,watch和update。

V1 /服务:

- List

- Get

- Watch

- Patch

- Update

PersistentVolumeLabels控制器

PersistentVolumeLabels控制器侦听PersistentVolume(PV)创建事件,然后更新它们。该控制器需要访问以获取和更新PV。

V1 / PersistentVolume:

- Get

- List

- Watch

- Update

其他

CCM核心的实现需要访问以创建事件,并且为了确保安全操作,它需要访问以创建ServiceAccounts。

V1 /事件:

- Create

- Patch

- Update

V1 / ServiceAccount:

- Create

CCM的RBAC ClusterRole如下所示:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59apiVersion: rbac.authorization.k8s.io/v1

kind: ClusterRole

metadata:

name: cloud-controller-manager

rules:

- apiGroups:

- ""

resources:

- events

verbs:

- create

- patch

- update

- apiGroups:

- ""

resources:

- nodes

verbs:

- '*'

- apiGroups:

- ""

resources:

- nodes/status

verbs:

- patch

- apiGroups:

- ""

resources:

- services

verbs:

- list

- patch

- update

- watch

- apiGroups:

- ""

resources:

- serviceaccounts

verbs:

- create

- apiGroups:

- ""

resources:

- persistentvolumes

verbs:

- get

- list

- update

- watch

- apiGroups:

- ""

resources:

- endpoints

verbs:

- create

- get

- list

- watch

- update

供应商实施

以下云提供商已实施CCM:

群集管理

此处提供了有关配置和运行CCM的完整说明

容器

镜像

您创建Docker镜像并将其推送到仓库,然后在Kubernetes的pod中引用它。

image容器的属性支持与docker命令相同的语法,包括私有仓库和标记。

- 更新镜像

- 用清单构建多架构镜像

- 使用私人仓库

更新镜像

默认拉取策略IfNotPresent会导致Kubelet跳过拉动镜像(如果已存在)。如果您想总是强制Docker拉动,可以执行以下操作之一:

- 将

imagePullPolicy容器设置为Always。 - 省略

imagePullPolicy并使用它:latest作为要使用的镜像的标记。 - 省略

imagePullPolicy要使用的镜像和标记。 - 启用AlwaysPullImages准入控制器。

请注意,您应该避免使用:latest标记,有关详细信息,请参阅配置的最佳实践。

用清单构建多架构图像

Docker CLI现在支持以下命令docker manifest中包含的子命令create,annotate并push。这些命令可用于构建和推送清单。您可以使用docker manifest inspect查看清单。

请在此处查看docker文档,

请参阅我们在构建工具中如何使用它的示例&i=nope&files=&repos=)。

这些命令完全依赖于Docker CLI,并且完全在Docker CLI上实现。您需要编辑$HOME/.docker/config.json和设置experimental密钥,enabled或者只需在调用CLI命令时将DOCKER_CLI_EXPERIMENTAL环境变量设置为enabled。

注意:请使用Docker 18.06或更高版本,以下版本有错误或不支持实验命令行选项。示例会在containerd下导致问题。

如果您在上传陈旧的清单时遇到问题,只需清理旧的清单$HOME/.docker/manifests即可重新开始。

对于Kubernetes,我们通常使用带后缀的镜像-$(ARCH)。为了向后兼容,请生成带有后缀的旧镜像。我们的想法是生成pause具有所有拱形清单的说明镜像,并说出pause-amd64哪些向后兼容旧配置或YAML文件,这些文件可能硬编码带有后缀的镜像。

使用私人仓库

私人仓库管理可能需要密钥才能从中读取图像。凭证可以通过多种方式提供:

- 使用Google Container Registry

- Per-cluster

- 在Google Compute Engine或Google Kubernetes Engine上自动配置

- 所有pod都可以读取项目的私有仓库

- 使用AWS EC2容器仓库(ECR)

- 使用IAM角色和策略来控制对ECR存储库的访问

- 自动刷新ECR登录凭据

- 使用Azure容器仓库(ACR)

- 使用IBM Cloud Container Registry

- 配置节点以验证私有仓库

- 所有pod都可以读取任何已配置的私有仓库

- 需要集群管理员进行节点配置

- 预拉镜像

- 所有pod都可以使用节点上缓存的任何镜像

- 需要root权限才能设置所有节点

- 在Pod上指定ImagePullSecrets

- 只有提供自己密钥的pod才能访问私有仓库

下面更详细地描述每个选项。

使用Google Container Registry

在Google Compute Engine(GCE)上运行时,Kubernetes对Google Container Registry(GCR)提供原生支持。如果您在GCE或Google Kubernetes Engine上运行群集,只需使用完整的镜像名称(例如gcr.io/my_project/image:tag)。

群集中的所有pod都具有此仓库中镜像的读取权限。

kubelet将使用实例的Google服务帐户向GCR进行身份验证。实例上的服务帐户将具有一个 https://www.googleapis.com/auth/devstorage.read_only,因此它可以从项目的GCR中提取,但不能推送。

使用AWS EC2 Container Registry

当节点是AWS EC2实例时,Kubernetes对AWS EC2 Container Registry具有本机支持。

只需ACCOUNT.dkr.ecr.REGION.amazonaws.com/imagename:tag在Pod定义中使用完整的图像名称(例如)。

可以创建pod的群集的所有用户都可以运行使用ECR仓库中任何镜像的pod。

kubelet将获取并定期刷新ECR凭据。它需要以下权限才能执行此操作:

- ecr:GetAuthorizationToken

- ecr:BatchCheckLayerAvailability

- ecr:GetDownloadUrlForLayer

- ecr:GetRepositoryPolicy

- ecr:DescribeRepositories

- ecr:ListImages

- ecr:BatchGetImage

要求:

- 您必须使用kubelet版本

v1.2.0或更新版本。(例如run/usr/bin/kubelet --version=true)。 - 如果您的节点位于区域A中且您的注册表位于不同的区域B中,则需要

v1.3.0更新版本或更新版本。 - ECR必须在您所在的地区提供

故障排除:

- 验证上述所有要求。

us-west-2在工作站上获取$ REGION(例如)凭据。SSH进入主机并使用这些信用卡手动运行Docker。它有用吗?- 验证kubelet是否正在运行

--cloud-provider=aws。 - 检查kubelet日志(例如

journalctl -u kubelet)以获取日志行,例如:plugins.go:56] Registering credential provider: aws-ecr-keyprovider.go:91] Refreshing cache for provider: *aws_credentials.ecrProvider

使用Azure容器仓库(ACR)

使用Azure容器仓库时, 您可以使用管理员用户或服务主体进行身份验证。在任何一种情况下,身份验证都通过标准Docker身份验证完成 这些说明假定使用 azure-cli命令行工具。

您首先需要创建一个仓库并生成凭据,完整的文档可以在Azure容器仓库文档中找到。

创建容器仓库后,您将使用以下凭据登录:

DOCKER_USER:服务主体或管理员用户名DOCKER_PASSWORD:服务主体密码或管理员用户密码DOCKER_REGISTRY_SERVER:${some-registry-name}.azurecr.ioDOCKER_EMAIL:${some-email-address}

填好这些变量后,您可以配置Kubernetes Secret并使用它来部署Pod。

使用IBM Cloud Container Registry

IBM Cloud Container Registry提供了一个多租户私有镜像仓库,您可以使用它来安全地存储和共享Docker镜像。默认情况下,集成的漏洞顾问会扫描私有仓库中的镜像,以检测安全问题和潜在漏洞。IBM Cloud帐户中的用户可以访问您的镜像,也可以创建令牌以授予对仓库命名空间的访问权限。

要安装IBM Cloud Container Registry CLI插件并为镜像创建命名空间,请参阅IBM Cloud Container Registry入门。

您可以使用IBM Cloud Container Registry将容器从IBM Cloud公共镜像和私有镜像部署到defaultIBM Cloud Kubernetes Service集群的命名空间中。要将容器部署到其他名称空间,或使用来自其他IBM Cloud Container Registry区域或IBM Cloud帐户的镜像,请创建Kubernetes imagePullSecret。有关更多信息,请参阅从镜像构建容器。

配置节点以验证私有仓库

注意:如果您在Google Kubernetes Engine上运行,则

.dockercfg每个节点上都会有一个包含Google Container Registry凭据的节点。你不能使用这种方法。

注意:如果您在AWS EC2上运行并且正在使用EC2容器仓库(ECR),则每个节点上的kubelet将管理和更新ECR登录凭据。你不能使用这种方法

注意:如果您可以控制节点配置,则此方法是合适的。它不能可靠地在GCE和任何其他进行自动节点替换的云提供商上运行。

Docker将私有仓库的密钥存储在$HOME/.dockercfg或$HOME/.docker/config.json文件中。如果您将相同的文件放在下面的搜索路径列表中,则kubelet会在拉取镜像时将其用作凭据提供程序。

{--root-dir:-/var/lib/kubelet}/config.json{cwd of kubelet}/config.json${HOME}/.docker/config.json/.docker/config.json{--root-dir:-/var/lib/kubelet}/.dockercfg{cwd of kubelet}/.dockercfg${HOME}/.dockercfg/.dockercfg

注意:您可能必须

HOME=/root在环境文件中明确设置kubelet。

以下是配置节点以使用私有仓库的建议步骤。在此示例中,在桌面/笔记本电脑上运行这些:

docker login [server]针对要使用的每组凭据运行。这更新$HOME/.docker/config.json。$HOME/.docker/config.json在编辑器中查看以确保它仅包含您要使用的凭据。- 获取节点列表,例如:

- 如果你想要这些名字:

nodes=$(kubectl get nodes -o jsonpath='{range.items[*].metadata}{.name} {end}') - 如果你想获得IP:

nodes=$(kubectl get nodes -o jsonpath='{range .items[*].status.addresses[?(@.type=="ExternalIP")]}{.address} {end}')

- 将本地复制

.docker/config.json到上面的搜索路径列表之一。

- 例如:

for n in $nodes; do scp ~/.docker/config.json root@$n:/var/lib/kubelet/config.json; done

通过创建使用私有镜像的pod进行验证,例如:1

2

3

4

5

6

7

8

9

10

11

12

13kubectl create -f - <<EOF

apiVersion: v1

kind: Pod

metadata:

name: private-image-test-1

spec:

containers:

- name: uses-private-image

image: $PRIVATE_IMAGE_NAME

imagePullPolicy: Always

command: [ "echo", "SUCCESS" ]

EOF

pod/private-image-test-1 created

如果一切正常,那么过了一会儿,你应该看到:1

2kubectl logs private-image-test-1

SUCCESS

如果失败了,那么你会看到:1

2kubectl describe pods/private-image-test-1 | grep "Failed"

Fri, 26 Jun 2015 15:36:13 -0700 Fri, 26 Jun 2015 15:39:13 -0700 19 {kubelet node-i2hq} spec.containers{uses-private-image} failed Failed to pull image "user/privaterepo:v1": Error: image user/privaterepo:v1 not found

您必须确保群集中的所有节点都具有相同的节点.docker/config.json。否则,pod将在某些节点上运行,而无法在其他节点上运行。例如,如果使用节点自动缩放,则每个实例模板都需要包含.docker/config.json或装载包含它的驱动器。

将私有仓库项添加到任何私有仓库中后,所有pod都将具有对镜像的读访问权限.docker/config.json。

预拉图像

注意:如果您在Google Kubernetes Engine上运行,则.dockercfg每个节点上都会有一个包含Google Container Registry凭据的节点。你不能使用这种方法。

注意:如果您可以控制节点配置,则此方法是合适的。它不能可靠地在GCE和任何其他进行自动节点替换的云提供商上运行。

默认情况下,kubelet将尝试从指定的仓库中提取每个镜像。但是,如果imagePullPolicy容器的属性设置为IfNotPresent或Never,则使用本地镜像(分别优先或排他)。

如果您希望依赖预先提取的镜像作为仓库身份验证的替代,则必须确保群集中的所有节点都具有相同的预拉镜像。

这可以用于预加载某些镜像以提高速度,或者作为对私有仓库进行身份验证的替代方法。

所有pod都可以读取任何预拉镜像。

在Pod上指定ImagePullSecrets

注意:此方法目前是Google Kubernetes Engine,GCE以及自动创建节点的任何云提供商的推荐方法。

Kubernetes支持在pod上指定仓库项。

使用Docker配置创建机密

运行以下命令,替换相应的大写值:1

2kubectl create secret docker-registry myregistrykey --docker-server=DOCKER_REGISTRY_SERVER --docker-username=DOCKER_USER --docker-password=DOCKER_PASSWORD --docker-email=DOCKER_EMAIL

secret/myregistrykey created.

如果需要访问多个仓库,则可以为每个仓库创建一个秘密。 在为Pods提取镜像时,Kubelet会将任何内容合并imagePullSecrets为一个虚拟内容.docker/config.json。

Pod只能在自己的命名空间中引用镜像拉取秘密,因此每个命名空间需要执行一次此过程。

绕过kubectl会产生秘密

如果由于某种原因,您需要单个项目中的多个项目.docker/config.json或需要上述命令未给出的控制,那么您可以使用json或yaml创建一个秘密。

务必:

- 设置数据项的名称

.dockerconfigjson - base64编码docker文件并粘贴该字符串,不间断作为字段的值

data[".dockerconfigjson"] - 设置

type为kubernetes.io/dockerconfigjson

例:1

2

3

4

5

6

7

8apiVersion: v1

kind: Secret

metadata:

name: myregistrykey

namespace: awesomeapps

data:

.dockerconfigjson: UmVhbGx5IHJlYWxseSByZWVlZWVlZWVlZWFhYWFhYWFhYWFhYWFhYWFhYWFhYWFhYWFhYWxsbGxsbGxsbGxsbGxsbGxsbGxsbGxsbGxsbGxsbGx5eXl5eXl5eXl5eXl5eXl5eXl5eSBsbGxsbGxsbGxsbGxsbG9vb29vb29vb29vb29vb29vb29vb29vb29vb25ubm5ubm5ubm5ubm5ubm5ubm5ubm5ubmdnZ2dnZ2dnZ2dnZ2dnZ2dnZ2cgYXV0aCBrZXlzCg==

type: kubernetes.io/dockerconfigjson

如果收到错误消息error: no objects passed to create,则可能表示base64编码的字符串无效。如果收到类似的错误消息Secret "myregistrykey" is invalid: data[.dockerconfigjson]: invalid value ...,则表示数据已成功取消base64编码,但无法解析为.docker/config.json文件。

参考Pod上的imagePullSecrets

现在,您可以通过向imagePullSecrets pod定义添加一个部分来创建引用该秘密的pod。1

2

3

4

5

6

7

8

9

10

11apiVersion: v1

kind: Pod

metadata:

name: foo

namespace: awesomeapps

spec:

containers:

- name: foo

image: janedoe/awesomeapp:v1

imagePullSecrets:

- name: myregistrykey

需要对使用私有仓库的每个pod执行此操作。

但是,可以通过在serviceAccount资源中设置imagePullSecrets来自动设置此字段。检查将ImagePullSecrets添加到服务帐户以获取详细说明。

您可以将其与每个节点结合使用.docker/config.json。凭证将被合并。这种方法适用于Google Kubernetes Engine。

用例

有许多配置私有仓库的解决方案。以下是一些常见用例和建议的解决方案。

- 群集仅运行非专有(例如开源)镜像。无需隐藏镜像。

- 在Docker hub上使用公共镜像。

- 无需配置。

- 在GCE / Google Kubernetes Engine上,自动使用本地镜像来提高速度和可用性。

- 群集运行一些专有镜像,这些镜像像应隐藏给公司外部的人员,但对所有群集用户可见。

- 使用托管的私有Docker仓库。

- 它可能托管在Docker Hub或其他地方。

- 如上所述,在每个节点上手动配置

.docker / config.json。

- 或者,使用开放读取访问权限在防火墙后面运行内部私有仓库。

- 不需要Kubernetes配置。

- 或者,在使用GCE / Google Kubernetes Engine时,请使用该项目的Google Container Registry。

- 与集群自动调节相比,它可以比手动节点配置更好地工作。

- 或者,在更改节点配置不方便的群集上,请使用

imagePullSecrets。

- 具有专有镜像的集群,其中一些需要更严格的访问控制。

- 确保AlwaysPullImages准入控制器处于活动状态。否则,所有Pod都可能访问所有镜像。

- 将敏感数据移动到“秘密”资源中,而不是将其打包在镜像中。

- 一个多租户群集,每个租户都需要拥有私有仓库。

- 确保AlwaysPullImages准入控制器处于活动状态。否则,所有租户的所有Pod都可能访问所有图像。

- 运行需要授权的私有仓库。

- 为每个租户生成仓库凭据,保密,并为每个租户命名空间填充机密。

- 租户将这个秘密添加到每个命名空间的imagePullSecrets。

容器环境变量

此页面描述Container环境中Container可用的资源。

容器环境

Kubernetes Container环境为容器提供了几个重要资源:

- 文件系统,是镜像和一个或多个卷的组合。

- 有关Container本身的信息。

- 有关群集中其他对象的信息。

容器信息

Container 的主机名是运行Container的Pod的名称。它可以通过 libc中的hostname命令或 gethostname函数调用获得。

Pod名称和命名空间可通过向下API作为环境变量使用 。

Pod定义中的用户定义环境变量也可用于Container,Docker镜像中静态指定的任何环境变量也是如此。

群集信息

创建Container时运行的所有服务的列表可作为环境变量用于该Container。这些环境变量与Docker链接的语法相匹配。

对于名为foo的映射到名为bar的Container 的服务,定义了以下变量:1

2FOO_SERVICE_HOST=<the host the service is running on>

FOO_SERVICE_PORT=<the port the service is running on>

服务具有专用IP地址,如果启用了DNS插件,则可通过DNS使用Container 。

运行时类

特征状态: Kubernetes v1.12

该页面描述了RuntimeClass资源和运行时选择机制。

此功能目前处于alpha状态,意思是:

版本名称包含alpha(例如v1alpha1)。

可能是马车。启用该功能可能会暴露错误。默认情况下禁用。

可随时删除对功能的支持,恕不另行通知。

API可能会在以后的软件版本中以不兼容的方式更改,恕不另行通知。

由于错误风险增加和缺乏长期支持,建议仅在短期测试集群中使用。

运行时类

RuntimeClass是一个alpha功能,用于选择用于运行pod容器的容器运行时配置。

建立

作为早期的alpha功能,必须采取一些额外的设置步骤才能使用RuntimeClass功能:

- 启用RuntimeClass功能门(在apiservers&kubelets上,需要1.12+版本)

- 安装RuntimeClass CRD

- 在节点上配置CRI实现(取决于运行时)

- 创建相应的RuntimeClass资源

1.启用RuntimeClass feature gate

有关启用feature gates的说明,请参见feature gates。必须在apiservers和kubelet上启用RuntimeClass功能门。

2.安装RuntimeClass CRD

RuntimeClass CustomResourceDefinition(CRD)可以在Kubernetes git repo的addons目录中找到:kubernetes / cluster / addons / runtimeclass / runtimeclass_crd.yaml

安装CRD kubectl apply -f runtimeclass_crd.yaml。

3.在节点上配置CRI实现

使用RuntimeClass进行选择的配置取决于CRI实现。有关如何配置的信息,请参阅CRI实现的相应文档。由于这是一个alpha功能,并非所有CRI都支持多个RuntimeClasses。

注意: RuntimeClass当前假定整个集群中的同类节点配置(这意味着所有节点的配置方式与容器运行时相同)。任何异构性(变化的配置)必须通过调度功能独立于RuntimeClass进行管理(请参阅将Pod分配给节点)。

配置具有相应的RuntimeHandler名称,由RuntimeClass引用。RuntimeHandler必须是有效的DNS 1123子域(字母数字+ -和.字符)。

4.创建相应的RuntimeClass资源

步骤3中的配置设置应各自具有关联的RuntimeHandler名称,用于标识配置。对于每个RuntimeHandler(以及可选的空””处理程序),创建相应的RuntimeClass对象。

RuntimeClass资源当前只有2个重要字段:RuntimeClass name(metadata.name)和RuntimeHandler(spec.runtimeHandler)。对象定义如下所示:1

2

3

4

5

6

7apiVersion: node.k8s.io/v1alpha1 # RuntimeClass is defined in the node.k8s.io API group

kind: RuntimeClass

metadata:

name: myclass # The name the RuntimeClass will be referenced by

# RuntimeClass is a non-namespaced resource

spec: